Music Produktion mit Game Engines!?

Vorwort der Redaktion:

Der folgende Beitrag und alle Bilder, wurden uns von Christian Pössnicker geschickt, mit der Bitte um Veröffentlichung. Dieser Bitte kommen wir natürlich sehr gerne nach, da wir das Thema enorm spannend finden. Nun sind wir gespannt, wie Ihr dazu steht. Wir übergeben an dieser Stelle an Christian Pössnicker:

Die flexibelste Reverb und Raumsimulation for free!

Naja „for free!“ ist etwas übertrieben, da etwas Zeit und Geduld investiert werden muss. Aber an Flexibilität ist der Reverb mit Plugins aktuell nicht zu überbieten.

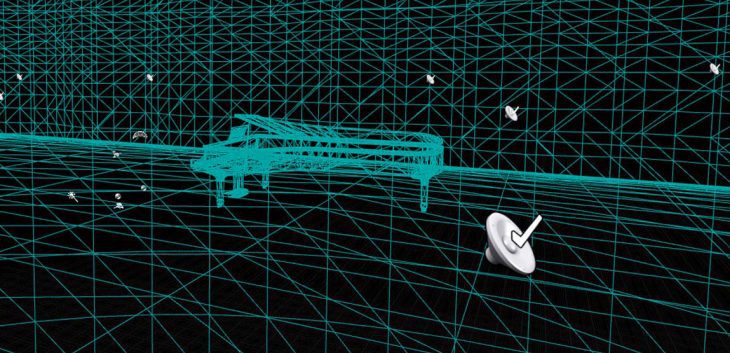

Die Idee ist ganz einfach. Computer Game Engines simulieren Schallwellen und deren Ausbreitung und Reflexion an Wänden und Objekten (Wavetracing). Der Gedanke dahinter ist, dass Klangobjekte in der 3d Game Welt platziert werden können welche dann akustisch Informationen über deren Position im Raum und die Raumgegebenheiten (Halle, Korridor, Höhle, etc.) wiedergeben. Dies hilft dem Spieler sich in der Spielwelt zurechtzufinden, Gegner zu orten und das Erlebnis „Immersiver“ zu gestalten. Soweit so gut.

Soll nun in der Musikproduktion ein Sound mit Hall versehen werden, so hat man klassischerweise zwei Optionen:

Zum einen können algorithmische Hall Simulationen verwendet werden. Hier wird der Hall, wie der Name schon verrät, algorithmisch berechnet.

Die zweite Option sind Impulse Response Reverbs. Hierbei wird die Raumantwort eines reellen Raumes als Impuls aufgezeichnet und kann dann auf ein Signal gerechnet werden. Die Vorteile eines algorithmischen Halls sind die immense Flexibilität und die umfangreichen Klangformungsmöglichkeiten. Endlos reverbs, kurze slap reverbs, alles ist möglich.

Häufig können diese reverbs ihren „künstlichen“ Charakter aber nicht verbergen. Dies ist natürlich nicht schlimm, da es in der Musikproduktion selten um akustischen „Realismus“ geht. Wenn es dann aber um überzeugende Räume geht führt kein Weg am impulse response reverb vorbei. Die Hallantworten sind meist ohne viel Arbeit absolut überzeugend, geben den Produzent*innen allerdings wenig Flexibilität.

Hier kommen Game Engines ins Spiel:

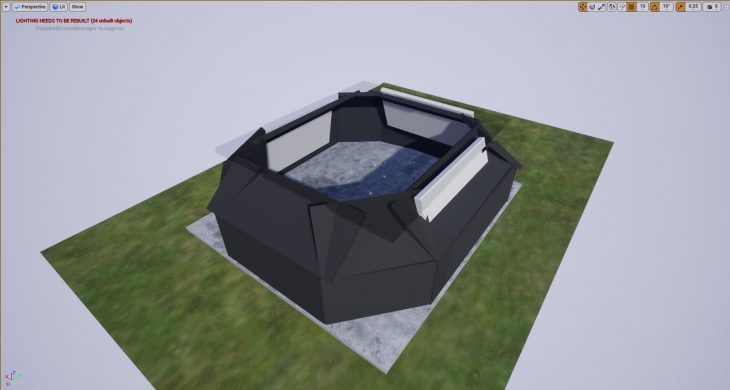

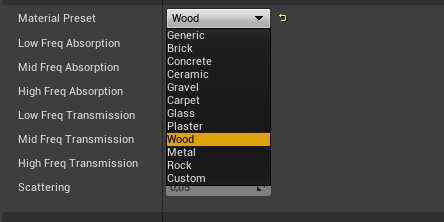

Es ist nun möglich einen Raum in der Engine zu designen und den Wänden phonetische Eigenschaften zuzuweisen.

Hier können verschiedene Materialien ausgewählt werden. Je nach Beschaffenheit und Größe des Raumes klingt der Hall dann dementsprechend.

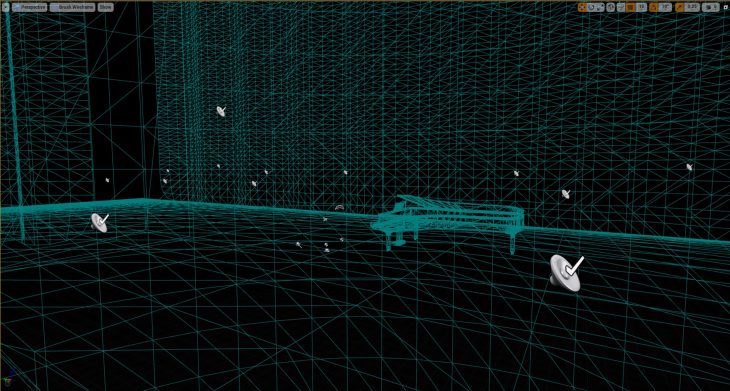

Aber nicht nur die Größe und Beschaffenheit des Raumes werden berücksichtigt, sondern auch die Position der Schallquelle. Befindet sich das Klangobjekt in der linken Ecke des Raumes, so klingt es anders als in der rechten, da die Reflektionen an den Wänden/ Objekten im Raum unterschiedlich sind. Somit werden gewissermaßen die Vorteile des Impulse Response Reverbs („echter akustischer Raum“) mit denen des algorithmischen Reverbs (maximale Flexibilität) kombiniert.

Jetzt haben wir einen Song in unserer Lieblings DAW und überlegen uns wie wir die „Räumlichkeit“ erzeugen wollen. Dazu wird ein Raum in der Game Engine, beispielsweise der Unreal Engine, modelliert. Es kommt hier weniger auf die visuellen Qualitäten des Raumes an, sondern eher auf die verwendeten phonetischen Materialien der Wände und vor allem die Größe des Raumes. Spannend sind vor allem asymmetrische Räume, da sie später ein sehr räumliches Klangbild erzeugen.

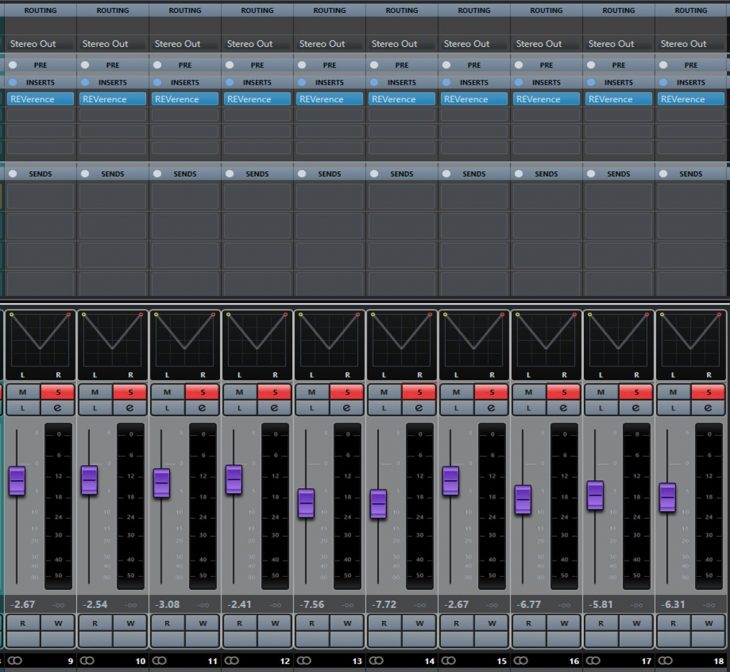

Im nächsten Schritt werden alle Spuren gebounced, welche wir in unserem Raum platzieren wollen. Diese erstellten waves files können nun als Objekt in die Game Engine geladen werden.

Wurde alles so platziert wie man es gerne hätte positioniert man sich, den Hörer, selbst.

Nun können entweder alle Spuren gleichzeitig abgespielt und dann aufgenommen werden, oder es wird Spur für Spur durchgegangen und alles später, in der DAW, wieder zusammen gefügt.

Für die maximale Flexibilität und auch um im Nachhinein noch Veränderungen am Sound durchführen zu können können auch Impuls Antworten der jeweiligen Positionen aufgenommen werden.

Weitere Möglichkeiten sich diese Technik zunutze zu machen findet man wenn man an Ambisonic Mixing denkt. Gerade beim mischen in dolby atmos dünnt sich die Plugin Liste erfahrungsgemäß deutlich aus. Mit der Möglichkeit auch Mehrkanal Outputs von Gameengines zu erzeugen (wie Beispielsweise dem 7.1.4 Format) können so die Optionen bedeutend erweitert werden.

Und hier von Christian ein YouTube Video zum Artikel:

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Wofür könnten diese Möglichkeiiten der Bildung von Reverb-Informationen interessant sein? Einfallen würden mir spontan Games, Filmmusik als auch Hörspiele. Weniger geeignet wären die Schaffung für Musik, die in Räumen stattfindet, die durch Impulse (IRs) bereits abgedeckt sind: Halls, Chambers, Bühne, Theater usw. Ich selber setze speziell gerne Chambers aus dem Lexicon 960L ein, beispielhaft zu hören auf Soundcloud in meinem Duet für Vocal und klassischer Gitarre:

https://soundcloud.com/helge-bol/duet-vocal-cl-guitar?in=helge-bol/sets/vocal-studies

@MidiDino Gerade als herausragender Ausnahmekünstler, der schon gekonnt die Grenzen von Stimm- und Melodieführung sowie der Harmonielehre weit hinter sich gelassen hat… warum sollte man sich von den Einschränkungen vorgefertigter IRs und starrer Algorithmen fesseln lassen?

Insofern wundert mich der Kommentar etwas.

Gerade für die Speerspitze der Avantgarde sollten doch die immensen Möglichkeiten der Raumgestaltung ein neues Universum an Möglichkeiten bereitstellen.

@Eisenberg Ich kümmere mich mal nicht um die artikulierte Spitze. Die jeweiligen Rauminformationen gehören zu den Bedingungen von Musik, auch wenn sie mit der Musik erklingen. Auch lassen sich IRs in modernen Engines durchaus im Klang verändern, zudem decken IRs bereits den Bedarf in Postproduktionen (Film usw.) ab. Die im Artikel besprochene Software könnte in Games, Flm usw. zusätzlich eingesetzt werden … z.B. für Experimente, wenn sie plausibel erscheinen können.

Falls man Reverb lediglich als beliebigen Effekt begreift, könnte ich deinen Einwand verstehen, aber auch nur dann.

@Eisenberg Also Audio Processing ist erstmal Audio Processing, ob das in der Unreal-Engine oder in einem Plugin stattfindet, daher verstehe ich nicht wieso davon ausgegangen wird, dass nur weil ein Audio-Plugin in der UE Engine eingebettet ist, sich daraus neue Möglichkeiten ergeben sollten, die es vorher nicht gab. Es gibt doch genau so viele wunderbare Reverb Plugins (auf Algorithmus Basis) wo man tonnenweise Regler und Settings hat um alles bis ins kleinste Detail finezutunen, und wenn man das dann noch um die Mixing Console in seiner DAW und andere Plugins ergänzt, dürfte das dem was man hier in der UE machen kann in nichts nachstehen. Gut, man kann den Wänden verschiedene Eigenschaften geben, aber ich bezweifle dass man das bei den anderen 10.000 Möglichkeiten die man beispielsweise bereits in einem Valhalla Vintage Verb für 50€ hat wirklich mit Mehrwert raushören würde.

Cool, spannender Ansatz, vielen Dank dafür!

Wäre sicher interessant, eine Art Rewire Plugin als Brücke zur Unreal Engine zu haben, womit sich die Audiosignale in Echtzeit übertragen ließen. Und das Ergebnis dann als Return wieder in der DAW.

Wie leistungshungrig ist denn das Wavetracing?

@Tom Techno Dankeschön! Ja ein rewire plugin wäre extrem hilfreich. Noch einfacher wäre es die UE als plugin in die DAW zu laden ;) Aber es gibt ein paar (zugegeben noch etwas unelegante) Lösungen für Echtzeitaudio in/out. So irrsinnig viel Power braucht wavetracing auf einem modernen System auch nicht. Das hängt natürlich von der Komplexität des Levels/Raumes und den Einstellungen der Materialien ab. Grundsätzlich lässt sich die Last aber gut verteilen (das Nvidia vr sdk lässt zB. die Berechnungen auf den RTX Kernen der Grafikkarte laufen). Im Video gehe ich auch auf einige Limitationen der Simulation ein die den Leistungshunger weiter bändigen.

Kreative Idee, toller Impuls. Danke fürs Forschen!

Irgendwann waybackwhen (ich würde vermuten, so als dicke DSPs groß wurden, also so Anfang 90er?) gab es sowas ähnliches als Effektgerät – Dinger, wo ich (freilich deutlich einfacher) einen Raum festlegen konnte. Hat sich irgendwie nie so richtig durchgesetzt (interessanterweise ebenso wie Physical-Modelling-Synths), und ich vermute auch weil ein Musiker/Tontechniker/Produzent meistens nicht den Klang eines zerklüfteten Raums mit bestimmtem Seitenverhältnis und Aluminiumoberflächen will, sondern eben nen Klang, der irgendwie viel Höhen und komplexe ERs hat oder so…

Ich war schon an der Stelle, mit Blender IRs zu berechnen, aber der vorgestellte Ansatz ist freilich deutlich mächtiger, wenn ich die Engine eben direkt als variable Übertragungsfunktion nutzen kann – auch wenn ich für meine Ziele wohl bei den algorithmischen Dingern bleib‘.

@moinho Könntest du vielleicht kurz erklären, wie du das generieren von IRs in Blender denn genau machen wolltest, oder hast du möglicherweise ein paar Links parat?

Ich kenne mich zwar mit Blender etwas aus, meine Kenntnisse reichen aktuell aber nur für die Erstellung eines Modells, kenne mich mit allem, was darüber hinausgeht, ehrlich gesagt nicht aus, irgendein Tutorial wäre somit echt Gold wert.

Ich habe schon dazu recherchiert, konnte aber bis jetzt nichts wirklich hilfreiches finden.

@c.poessnicker: wäre eine etwas detailliertere Erklärung / Anleitung für die etwas weniger versierten im Rahmen der Möglichkeiten? Mir geht es in erster Linie nur darum, fertige Tracks so erklingen zu lassen, als ob sie in dem jeweils modellierten Raum erklingen würden, da wäre es also ausreichend, ein paar IRs zu erstellen, nur müsste ich wissen, wie das genau geht (also was man, von der Erstellung des Modells mal abgesehen, in UE4 machen muss).

@Voyager Da hab‘ ich durch ne unpräzise Formulierung zu viel versprochen: damit meinte ich, wenn ich das brauchen würde, wüßte ich, wers kann (und wie es prinzipiell funktioniert) – aber mehr leider nicht.

@moinho Selbst wenn, schon alleine das würde mir ungemein helfen.

Wie gesagt, ich kenne mich mit Blender nur insofern aus, dass ich weiß, wie man ein Modell erstellt und vielleicht noch wie man mit den Materials im Node Editor arbeitet, aber das war es auch schon.

Daher bin ich für jeden Tipp dankbar, selbst wenn es nur um das grobe Prinzip geht. Sobald ich das Prinzip verstanden habe, dürfte es mir danach etwas leichter fallen, das weitere Vorgehen zu erarbeiten.

Sehr cooler Beitrag.

Und die Möglichkeit die Schallquellen im Raum zu automatisieren gibt es ja auch noch…

Gerade für die Hörspielproduktion ist sowas sehr zu gebrauchen.

Im Theater hat mich die Künstlichkeit der Hall Plugins immer gestört. Aber da war es auch live.

Warum tut jeder dem Spross des Hausherrn derart huldigen?

Des ist nix anderes wie die Usage eines beliebigen 3D-Plugins. 3D-Positionierung halt. So what? Was neues auf der Uni im Medienlabor gelernt?

Christian hat mir heute in den Kommentaren unter seinem Video auf Youtube geantwortet, dass er eine Videoserie plant, wo er das Vorgehen im Detail erläutern wird, kann es kaum erwarten :-)