Entwicklungen und Trends rund um Künstliche Intelligenz im Tonstudio

Obwohl der Hype rund um ChatGPT und Künstliche Intelligenz (kurz KI) etwas abgeflacht ist, werden täglich neue Produkte mit Künstlicher Intelligenz versehen. Diese Entwicklung macht auch vor Software für das Tonstudio nicht halt und auch Online-Services versprechen durch den KI-Einsatz bahnbrechende Neuerungen. Ich habe mich etwas umgeschaut und stelle euch einige dieser Anwendungsgebiete von KI und Tools in diesem Artikel vor.

Inhaltsverzeichnis

Was leistet Künstliche Intelligenz im Tonstudio?

Während ein Algorithmus in der Regel einem festen Verarbeitungsmuster folgt, ist eine Künstliche Intelligenz in der Lage, in Abhängigkeit des KI-Modells und der für das Training verwendeten Daten selbstständig eine Lösung für ein Problem zu erarbeiten. Zumindest scheint es für den Nutzer so. Der Begriff „Intelligenz“ ist etwas irreführend, denn von der Leistung unseres Gehirns, Lösungsstrategien zu erarbeiten, Entscheidungen zu treffen, abzuwägen, welche Lösung eher ans Ziel führt oder effizienter ist, was ethisch vertretbar ist und was nicht, ist KI weit entfernt. Dennoch bekommt Künstliche Intelligenz auf Basis eines Large Language Models (LLM) wie ChatGPT geradezu menschliche Züge. Gerade die Fähigkeit zur Kommunikation über Sprache ist schließlich ein Alleinstellungsmerkmal des Menschen.

Schauen wir uns zunächst einmal einige menschliche Fähigkeiten an, die gerade auch im Musikeralltag und im Tonstudio eine Rolle spielen:

Sprechen

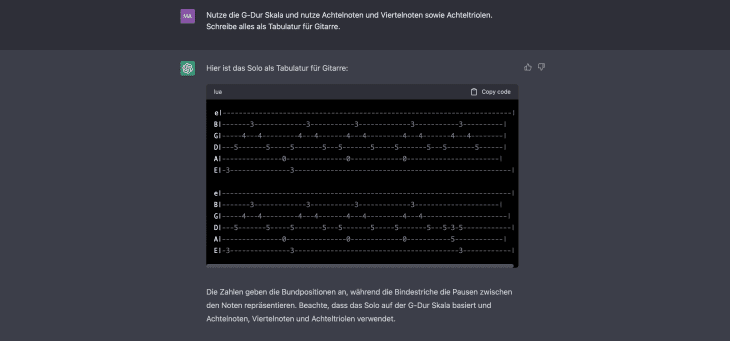

Mit ChatGPT wurde der Hype um Künstliche Intelligenz erst richtig gestartet. Sprachbasierte KI-Systeme, die Unterhaltungen mit den Nutzern führen, ermöglichen auch für die Musikproduktion neue Chancen.

Dem Computer einfach per Sprache mitteilen zu können, was von ihm erwartet wird, ist schon seit Jahrzehnten der Traum des Menschen. Statt über mehr oder weniger komplexe Programmiersprachen mühsam zunächst eine Software zu erstellen, um eine bestimmte Aufgabe zu erledigen, gelingt dies mit KI deutlich einfacher.

Hören

Ein weiteres Alleinstellungsmerkmal des Menschen ist es, komplexe Hörerlebnisse zu „sezieren“ und zum Beispiel Tonfolgen, die ein Instrument innerhalb einer komplexen Mischung spielt, herauszuhören beziehungsweise die Instrumente zu erkennen. Wie bei einer Künstlichen Intelligenz erfordert das zwar mitunter auch etwas Training, doch selbst Laien sind in der Lage, Instrumente wie Bass, Schlagzeug, Gitarre oder Gesang „separiert“ zu hören. Auf diese Weise summen oder singen wir zum Beispiel die Melodie eines Songs mit. Mit etwas Training in Form von Gehörbildung sind Musiker in der Lage, noch genauer hinzuhören und zum Beispiel das Arrangement eines Songs zu analysieren und die einzelnen Instrumentalstimmen zu notieren. So hört sich der Gitarrist vielleicht die Akkorde der Rhythmusgitarre oder das Gitarrensolo heraus, während der Keyboarder sich auf die Keyboard-Parts konzentriert.

Dem Computer waren solche Höranalysen bislang fremd. Während das Notieren einer monophonen Audioaufnahme anhand der Frequenzanalyse noch halbwegs zufriedenstellend bewerkstelligt werden konnte, scheiterte der Computer bei polyphonen Aufnahmen oder komplexen Mischungen. So war es kaum möglich, einen Mix wieder in seine Bestandteile oder zumindest Stems zu zerlegen. All das hat sich mit KI verändert. Trainiert man einen Computer, auf dem ein KI-Modell läuft, mit entsprechenden Audioinformationen, ist auch er nun dank Künstlicher Intelligenz in der Lage, genauer hinzuhören und einen Mix zu separieren.

Sehen

Menschen und Tiere sind in der Lage, die Umwelt sehend wahrzunehmen. Nicht jedes Lebewesen sieht dabei gleich. Das Auge nimmt bestimmte Wellenlängen des Lichts wahr und das Gehirn setzt diese in Farben um. Welche Wellenlängen wahrgenommen werden und wie sie verarbeitet werden, ist dabei von Spezies zu Spezies verschieden. Hunde und Katzen sehen anders als ein Mensch. Manche Tiere können besser in der Dunkelheit sehen als ein Mensch, andere Tiere wie ein Adler entdecken auch kleinste Beutetiere aus sehr großer Entfernung. Das Erkennen von Formen und Mustern ist ein wesentlicher Bestandteil des Sehens. Insbesondere das Abstrahieren zählt zu den herausragendsten Fähigkeiten des Gehirns. So sieht jeder Baum anders aus, dennoch erkennen wir ihn als Baum. Und selbst das Gekrakel eines kleinen Kindes wird von unserem Gehirn entsprechend in die vom Kind gemeinten Objekte transformiert.

Computern war es bislang zwar möglich, Farben zu erkennen, bei komplexen Formen und Mustern hörten die Fähigkeiten allerdings auf. So konnte der Computer auf einem Bild zwar einen bestimmten Baum erkennen, aber nicht alle Bäume. Mit Künstlicher Intelligenz hat sich das verändert. Nun sind Bildanalysen für den Computer möglich. Sogar das Erstellen von Bildern aufgrund einer Textbeschreibung ist mittlerweile Wirklichkeit geworden. Das Erkennen von Mustern funktioniert mittlerweile so gut, dass ein Computer aus einer komplexen Orchesterpartitur eine Audiodatei generieren kann. Noch erstaunlicher sind die Ergebnisse in der Medizin: Kleinste Anomalien auf dem Bild einer Computertomografie, die selten größer als ein Pixel sind, werden vom Computer entdeckt, wenn er entsprechend trainiert wurde.

Künstliche Intelligenz in der Musikproduktion: Stems, Playbacks, Noten

Wie lässt sich eine Künstliche Intelligenz nun konkret in der Musikproduktion einsetzen beziehungsweise welche Produkte gibt es bereits?

Im letzten Teil wurden bereits Kompositions-Tools vorgestellt, die auf der Basis einiger vom Nutzer vorzugebender Parameter mehr oder weniger komplexe Musikstücke generieren. Doch auch der umgekehrte Weg ist möglich, nämlich das „Hören“ von Musik.

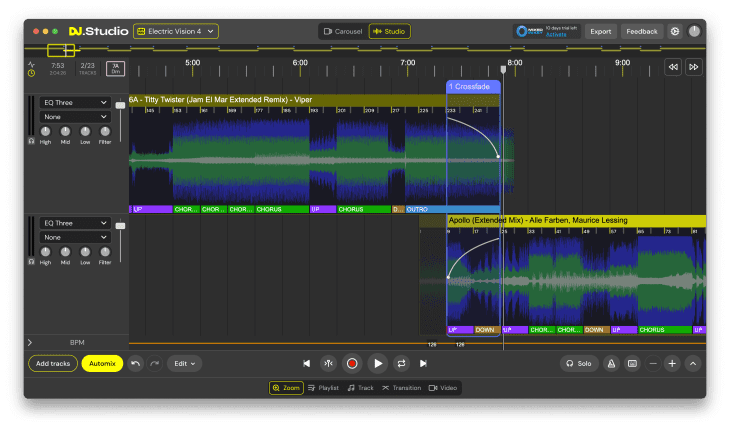

Stems erstellen

Das Erstellen von Stems, also einzelner Instrumentenspuren oder Gruppenspuren, ist eine häufige Aufgabe im Tonstudio. Benötigt werden diese zum Beispiel für das Erstellen eines Remixes. Dafür werden einzelne Bestandteile eines Musikstücks mit neuen Elementen kombiniert, der Ablauf oder die Harmonik eines Songs verändert beziehungsweise dessen Stil. Damit ein Remix erstellt werden kann, benötigt der Remixer zum Beispiel den Lead-Gesang als Einzelspur, die Background Vocals, die Instrumente oder zumindest Instrumentengruppen und so weiter. Beauftragt der Künstler oder sein Label einen Remix, werden die Stems in der Regel aus dem Multitrack DAW-Projekt des Originals ausgespielt. Hier ist der Zugriff auf die Einzelspuren möglich und es kann exakt das ausgespielt werden, was der Remixer benötigt.

Anders sieht es aus, wenn der Zugriff auf die Einzelspuren nicht (mehr) möglich ist. Mittels Künstlicher Intelligenz wird der Computer heutzutage in die Lage versetzt, die wichtigsten Elemente eines Songs „freizustellen“. Dazu wird die KI mit dem Stereo-Mixdown des Songs gefüttert und analysiert diesen. Auf Basis der Trainingsdaten wird nun der Song in Stems für Schlagzeug, Bass, Gesang, Keyboards und Gitarre zerlegt – ganz ohne Handarbeit durch einen Menschen. Die Ergebnisse sind erstaunlich und noch vor wenigen Jahren wäre das nicht denkbar gewesen. Insbesondere das Extrahieren von Gesang ist eine Paradedisziplin vieler KI-gestützter Audio Tools.

Playbacks erstellen

Mit dieser Technologie lassen sich natürlich nicht nur Stems erstellen, sondern auch Playbacks. So ist innerhalb von Sekunden ein Instrumental-Playback ohne Gesang fertiggestellt oder ein Gitarren-Playalong. Auch das Entfernen der Drums ist für solche KI-Tools kein Problem. Etwas schwieriger wird das bei Keyboard-Instrumenten wie Synthesizer, Orgel oder Klavier. Während bei einfachen Songs auch hier das Separieren zufriedenstellend funktioniert, ist das bei komplexen Mischungen (noch) nicht möglich. So wird das Klavier noch oft mit einer clean gespielten Rhythmusgitarre verwechselt und Synthesizer-Sounds, die sich nicht selten über das gesamte Frequenzspektrum erstrecken, sind ebenfalls kaum voneinander zu trennen beziehungsweise finden sich als Fragmente später in den Stems anderer Instrumentengruppen wieder.

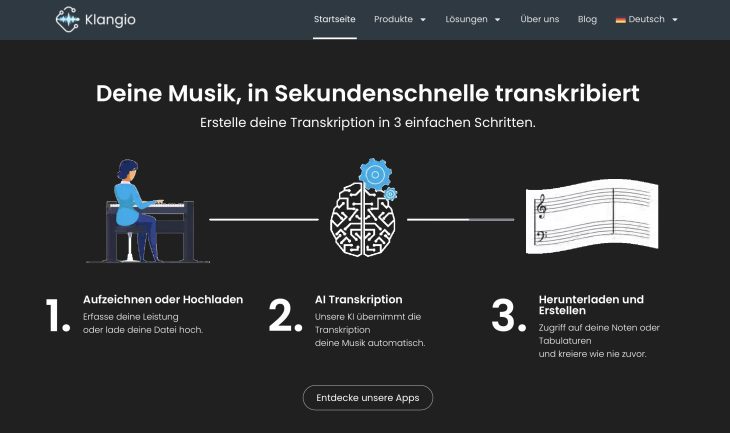

Noten schreiben/MIDI-Files erstellen

Das automatische Schreiben von Noten anhand einer Audiovorlage ist seit jeher der Traum von vielen Musikern. Schon lange gibt es Tools, die genau das versprechen. Bei monophonem Audiomaterial funktionierte das bislang auch schon ganz passabel. Jegliche Form von Polyphonie wurde bislang mit unbrauchbaren Ergebnissen bestraft. Mit dem Einsatz von Künstlicher Intelligenz ändert sich das nun. Wie schon bei der Erzeugung von Stems ist die KI in der Lage, die einzelnen Stimmen voneinander zu separieren und dem entsprechend dann auch eigenen Notensystemen zuzuweisen. Problematisch bleibt allerdings bei einer polyphonen Vorlage die Phrasierung, da die KI nicht immer eindeutig sagen kann, wie die Stimmführung aussieht, zum Beispiel wenn es sich um ein Klavierstück handelt. Hier ist nach wie vor viel Handarbeit angesagt. Auch das Erstellen von MIDI-Spuren aus Audiospuren ist möglich. Doch interessanter ist der Vorgang für den nächsten Punkt:

Änderungen an Harmonik, Melodik, Rhythmik fertiger Spuren, Stems oder Mixes

Der Take deines Lebens ist im Kasten, das Feeling stimmt, der Sound ist toll und doch gibt es Verbesserungsbedarf. Statt alles neu aufzunehmen und zu riskieren, dass die neuen Takes an einer anderen Stelle schlechter werden als das, was bereits aufgenommen wurde, bietet es sich an, einfach das aufgenommene Material zu bearbeiten. Was bei MIDI-Spuren eine triviale Angelegenheit ist, ist bei Audiospuren, insbesondere dann, wenn sie mit Effekten versehen sind, nicht ganz so leicht. Tools wie Melodyne bieten schon länger die Möglichkeit, nachträglich Veränderungen vorzunehmen. DAWs wie Logic Pro bieten mit Tools wie Flex gar interne Möglichkeiten zu einer derartigen Bearbeitung von Audiospuren.

Durch den Einsatz von Künstlicher Intelligenz lässt sich dieser Prozess auf komplette Stems oder fertige Mixes ausweiten. Die KI zerlegt den Mix in einzelne Bestandteile, analysiert diese, stellt das Analyse-Ergebnis als Notendarstellung oder Pianorolle dar und bietet den Produzenten nahezu die gleichen Editiermöglichkeiten, wie sie auch bei einer MIDI-Spur möglich wären. Die Änderungen werden im Anschluss von der KI wieder in das passende Audiomaterial überführt.

Künstliche Intelligenz für Mix und Mastering

Doch nicht nur in der Produktionsphase kommt KI zum Einsatz. Auch für den Mixdown und das Mastering ist der Einsatz künstlicher Intelligenz interessant. Manchmal arbeitet die KI dabei kaum für den Benutzer merkbar im Hintergrund, in anderen Fällen kommuniziert sie direkt mit dem Benutzer.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

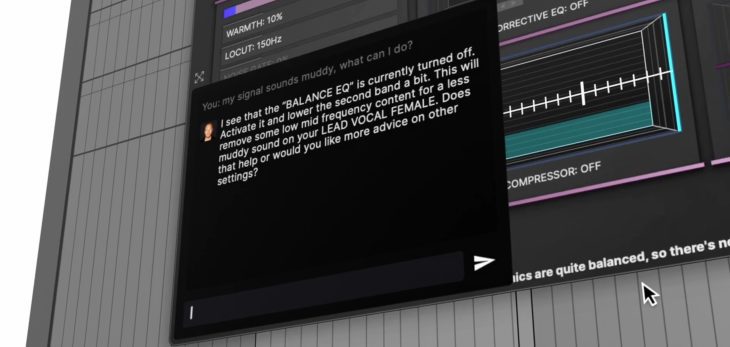

Mix-Tipps vom ChatBot im Homestudio

Erste Plug-ins analysieren das Audiosignal und passen die Parameter selbstständig an, um ein optimales Ergebnis zu erzielen. Manche Plug-ins führen durch den Mix- oder Mastering-Prozess und geben Tipps und Hinweise, wie das Ergebnis verbessert werden könnte. So integrieren zum Beispiel die Plug-ins von Phil Speiser wie zum Beispiel The Strip einen ChatBot, der darauf trainiert ist, Fehlerquellen aufzuspüren und Fragen der Nutzer zum Mix und zu den benötigten Plug-in-Einstellungen zu beantworten. Dem Computer einfach mitteilen zu können, wie das gewünschte Ergebnis aussehen soll, um dann von der KI eine Rückmeldung zu den passenden Einstellungen zu erhalten oder diese sogar automatisch vornehmen zu lassen, ist geradezu revolutionär.

Song- und Mix-Analyse im Tonstudio mit Hilfe von KI-Plug-ins

Channel-Strips wie iZotope Neutron 4 sind ebenfalls mit einer KI-Unterstützung versehen, um Nutzern das Einstellen des Plug-ins zu erleichtern und schneller zum gewünschten Klangergebnis zu gelangen. Dabei ist auch Tone-Matching möglich, also das Anpassen des eigenen Sounds an einen Referenz-Sound.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Sehr beeindruckend sind Tools, mit denen sich Gesangsaufnahmen per KI automatisch einem Referenz-Track anpassen lassen – inklusive EQ, Kompressor, Pitchshifting, Effekte. Führend ist hier zum Beispiel die iZotope Nectar 4 Vocal Mixing Software. Die Software separiert jeden beliebigen Vocal-Sound aus einem fertigen Mix und fertigt ein Profil des Sounds an, das dann auf eigene Vocal-Spuren angewendet werden kann. Per Auto-Level lassen sich Vocal-Tracks ohne Kompression automatisch gleichmäßiger gestalten, ganz so als würde ein Toningenieur beim Mix kontinuierlich den Pegel mit dem Fader angleichen. Der Unterschied zu Auto-Levellern ohne KI ist allerdings, dass die AI nur die tonalen Elemente des Tracks regelt und nicht auch enthaltenes Rauschen oder andere Störgeräusche, die sonst unweigerlich mit angehoben werden. Oder wie wäre es mit einem eigenen Background-Chor, generiert aus vorgefertigten Stimmen oder der eigenen Stimme? Auch hier hilft KI bei der Analyse des Signals und erzeugt Chorstimmen, die nicht nur sehr realistisch klingen, sondern sich auch perfekt den harmonischen Gegebenheiten des Songs anpassen.

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Eine Spezialität von KI ist das Verbessern von Audiotracks. Rauschen, Verzerrungen, Störgeräusche, zu viel Hall, schlechte Lautstärkeverhältnisse bei Dialogen, Knacken, Knistern und vieles mehr werden zuverlässig von der KI erkannt und beseitigt. Was früher mühsam von Hand ausgeführt werden musste, ist heute eine Sache von Sekunden. Die KI analysiert das Audiosignal und führt selbstständig die notwendigen Schritte durch, um zu einem optimalen Ergebnis zu gelangen.

Auphonic ist ein Web-Service zum Verbessern von fertigen Audioaufnahmen für Radio, Broadcast, Podcasts, Video, Hörbücher und mehr

Mastering mit künstlicher Intelligenz

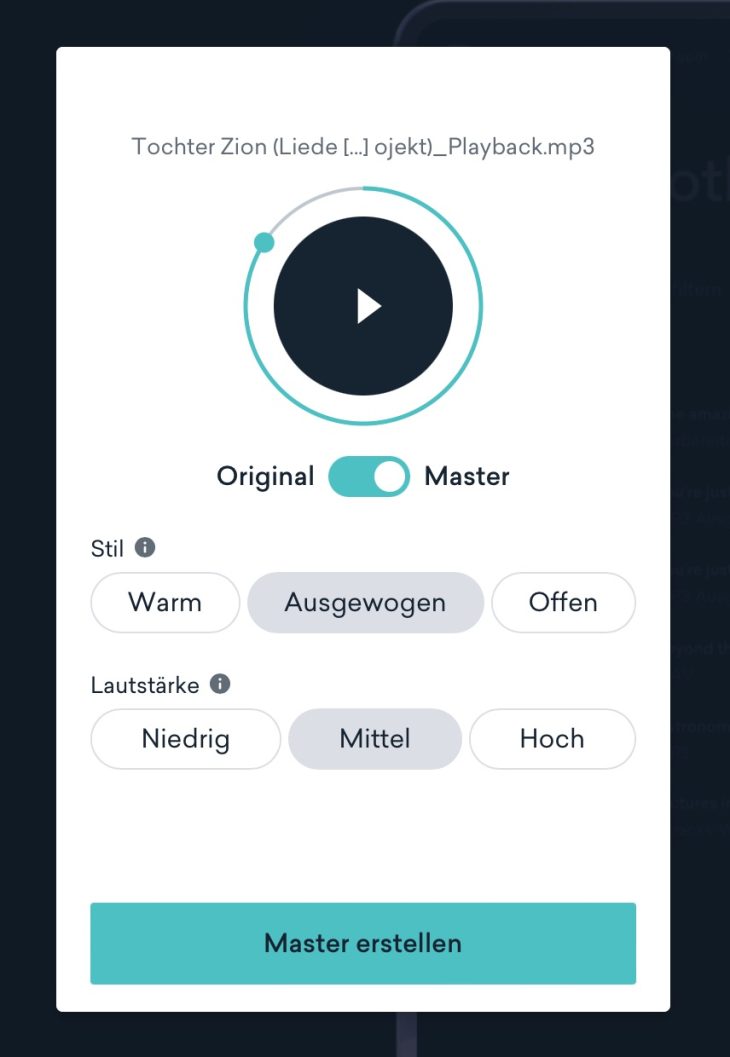

Ohnehin gehört das Mastering zu den anspruchsvollsten Stationen in der Musikproduktion. Es erfordert nicht nur hochwertiges Equipment, sondern benötigt auch ein geschultes Gehör und sehr viel Erfahrung. Mit der Hilfe von KI ist es durchaus möglich, zu ansprechenden Mastering-Ergebnissen für das eigene Album oder die eigene Single zu kommen. Dazu wurden KI-Algorithmen mit den Mastern verschiedener Toningenieure und unterschiedlicher Musikstile trainiert. Der eigene Mix wird analysiert, Schwachstellen aufgedeckt und anschließend werden die Parameter der Mastering-Algorithmen so von der KI konfiguriert, dass das Master entweder einer Vorlage ähnelt oder aber nach musikalischen oder technischen Kriterien vorgenommen wird. Einer der bekanntesten Online-Anbieter von KI-Mastering ist der Dienst LANDR (hier unser Test zum Mastering Plug-in). LANDR analysiert die Musik nach dem Hochladen und erkennt automatisch das Genre und das Subgenre. Nun werden im ersten Schritt alle Parameter an den erkannten Stil angepasst, der Frequenzgang harmonisiert, Lautstärken besser abgestimmt und mehr. Im Anschluss lassen sich Original und Master miteinander vergleichen. Es können nun noch Anpassungen vorgenommen werden, zum Beispiel aus drei Stilen (warm, ausgewogen, offen) gewählt oder die Lautstärke verändert werden (niedrig, mittel, hoch). Im Anschluss klickt man nur noch auf „Master erstellen“.

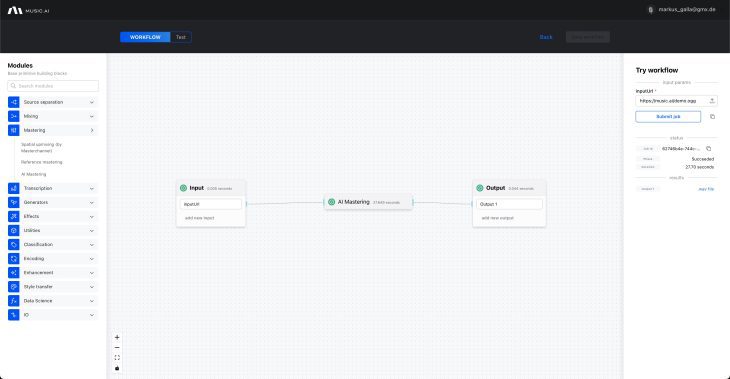

Andere Anbieter wie MUSIC.AI ermöglichen noch einen viel weitgehenderen Zugriff auf die einzelnen Stationen der Bearbeitung. Bei MUSIC.AI lassen sich zum Beispiel eigene Workflows aus verschiedenen KI-gestützten Modulen bilden. Über das Referenz- und vollautomatisch AI-Mastering hinaus stehen zahlreiche Module zur Auswahl, die beliebig miteinander kombiniert werden können.

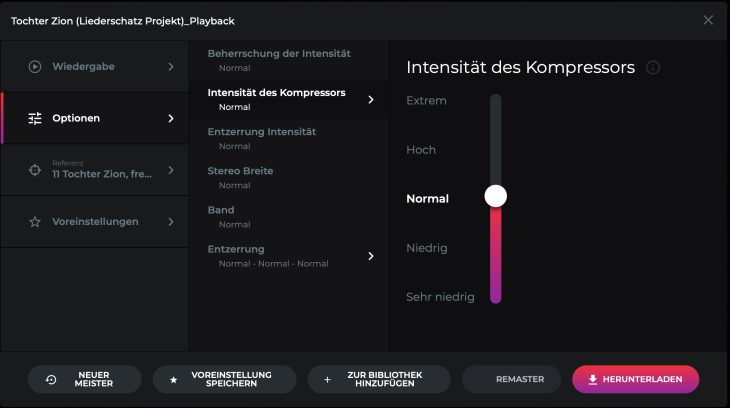

Ein weiterer Anbieter ist emastered.com. Auch hier erfolgt wie bei LANDR ein automatisches Mastering. Zusätzlich ist das Hochladen eines Referenz-Tracks möglich sowie weitergehende Anpassungen hinsichtlich der Kompression, des Klangs, der Stereobreite und mehr.

Die Ergebnisse sind wirklich erstaunlich. Aus einem leisen und dumpfen Mix wird plötzlich ein durchaus radiotauglicher Track – und das innerhalb von Sekunden oder wenigen Minuten. Natürlich lässt sich ein solches Mastering nicht mit einem Master von Legenden wie Bob Ludwig oder Bernie Grundman vergleichen. Bei der Vielzahl an Songs, die als Eigenproduktion im Heimstudio entstanden sind und dann auf Spotify oder Apple Music hochgeladen werden, ist ein solches Online-Mastering mit KI-Unterstützung jedoch eine deutliche Verbesserung und die Hörer werden es danken.

Ist tatsächlich noch nicht mein Thema aber die Zeit wird es zeigen. Als rechnerbasierter Musiker wird man sich früher oder später sich damit ggf. auseinandersetzen müssen. Aber ich verzichte gerne, trotz gewisser Vorteile. Aber man darf gar nicht sonderklug daher reden, denn auch ich verwende Algorithmen bei meinen Produktionen und möchte nicht mehr darauf verzichten. Vielleicht wird es eines Tages völlige Normalität. Wer hätte noch vor gut 30 Jahren damit gerechnet, dass (fast) jede Produktion über den Rechner oder gar Smartphone bearbeitet wird. Steinberg und Co. ebneten den Weg dafür und Google wird es morgen sein. 🫠

I remind Huxley’s Brave New World. (1932)

Der Mensch blendet sich selbst immer mehr aus und findet das auch noch richtig Super.

Unter dem Deckmäntelchen der Arbeitserleichterung und Zeitersparnis verlieren wir unser Können.

Autonome Fahrzeuge, „KI“-Musikkomposition usw. Wir verlieren erst Muskelmasse (durch überall nur noch aufs Knöpfchen drücken -Rest geht vollelektrisch-) später haben wir noch soviel Rückrat wie ein Eimer eingelegte Aale. Musik machen und auch wahrnehmen ist eines der emotionalsten Themen. Musikkomposition ohne den Faktor Mensch/Emotion/Erfahrung Gefühl/wissen um Fehler. Naja, Die Ergebnisse klingen entweder wie „Kunstlederimitat“, oder sind beliebig.

Ja, man kann Entscheidungshilfen von so genannter „KI“ in Form von EQ-Kurven oder Mastering-Vorschlägen in Erwägung ziehen. Aber selbst dabei geht uns Wissen ab.Ich finde es traurig.

Wir sollten als Menschen mehr auf uns acht geben.

Jeder der jetzt denkt: “ Mensch Junge, die Erde ist keine Scheibe mehr.“ – Hat nicht verstanden worum es uns gehen sollte.

Prost Leute🙂

Danke für diese ausführliche Zusammenfassung des Standes der Technik! Wer die angesprochene Software einmal ausprobiert, müsste eigentlich ziemlich ernüchtert sein. RipX und Izotope RX nutzen zur Stemseparation deutlich hörbar nur Frequenztrennung. Das einzig intelligente daran ist die selbstständige Frequenzanalyse. Verblüffende Ergebnisse sind nach meiner Erfahrung immer Glückstreffer. So ließ sich z.B. der Song D.I,S.C.O von 1980 mit RipX super separieren, ähnliche Songs aus der gleichen Zeit dagegen nicht. Erst wenn die Software auch den Stemtrack analysieren und die Reste anderer Instrumente entfernen und möglichst auch noch fehlende Frequenzen restaurieren könnte, wäre das Ergebnis sauber genug für einen Remix.

Bei der Notenerkennung werden Echos und Hallfahnen andauernd als Noten „erkannt“ und im Fall von Hallfahnen gerne auch noch als mehrere Noten hintereinander. Analysiere ich z.B. das Intro von „Arthur’s Theme“ von Christopher Cross mit Melodyne Editor, erhalte ich einen chaotischen Notenhaufen, aus dem sich nur mit Mühe ein paar Akkorde herauslesen lassen, aber noch nicht einmal die dominante Melodie. Hier käme ich nur durch Nachspielen nach Gehör zu einem Ergebnis.

Auch bei „Kompositionen“ durch angebliche KI muss ich immer noch mit meinem Gehör und meinem Talent gute Teile erkennen und vom nutzlosen Ausschuss trennen. Das wird KI wohl selbst niemals können.

@MartinM. Tatsächlich werden wir RipX in Kürze einem Test unterziehen.

Ich habe die Software schon mehrfach auf dem Prüfstand gehabt.

Beim ersten Mal waren die Ergebnisse super. Nach einigen Updates wurde ich vom Entwickler gebeten, sie erneut zu testen und ein Video zu produzieren. Die Ergebnisse waren fürchterlich. Kein Vergleich mehr zum ersten Test und Moises und Co waren deutlich besser.

Nun nennt sich RipX mittlerweile DAW und hängt werbeträchtig das Kürzel AI an. Die Erwartungen sind also dementsprechend groß. Ich werde mit dem Test bald starten und das Ergebnis könnt ihr dann hier lesen.

@Markus Galla Prima! Da bin ich mal gespannt!

Teste dann auch bitte die Verwendbarkeit von solchen Stems! Nach meiner Erfahrung kann man höchstens einen Stem jeweils „verwerten“. Hat man auch nur einen weiteren Track aus solch einer nachträglichen Separation im Mix, kann man nicht einmal einen EQ darauf anwenden, ohne heftige Phasingartefakte zu erhalten. Also für einen Remix eines separierten Songs wären sie gar nicht zu gebrauchen. Selbst ein „Rebalance“ der Lautstärke der Stems, wie es Izotope verspricht, erscheint mir schon kritisch. Die Programme scheinen die zu separierende Musik einfach nur an einer variablen Frequenzlinie zu splitten. Dann bleibt zwar in der Summe der Stems alles erhalten, man kann aber mit dem gesplitteten Ergebnis kaum etwas anfangen.

@MartinM. Leider kann ich von Stems kommerzieller Songs keine Hörbeispiele machen. Auffällig ist, dass man beim Hersteller nur Hörbeispiele von sehr aufgeräumt klingenden Eigenproduktionen findet. Das war auch mein Problem beim zweiten Test. Da ging es um den Einsatz im Musikunterricht, also Erstellen von Backing Tracks, Heraushören von Soli, Akkorderkennung usw. Und genau das funktionierte mit keinem einzigen Song. Deshalb habe ich die Erstellung des Tutorials damals abgelehnt. Mit der früheren Version ging das noch ganz gut. Die habe ich im Unterricht sogar einige Male eingesetzt. Ich bin gespannt.

@Markus Galla Ja, an das Copyrightproblem mit Testsongs habe ich auch schon gedacht. Es müsste schon jemand seine eigene Musik explizit dafür zur Verfügung stellen, und die sollte dann doch mit gängiger Populärmusik vergleichbar sein. Ich bin mir ziemlich sicher, dass man unter den Amazona Lesern genügend Freiwillige findet, wenn man nur fragt. Ich selbst würde durchaus Songs zur Verfügung stellen — inklusive aus der DAW gerenderten Original-Stems — allerdings kommen bei mir die Vocals aus der Software Yamaha Vocaloid, die nicht ganz den Charakter einer echten Gesangsstimme haben. Eventuell könnte man auch ein paar Übungssongs aus der Software Band in a Box von PG Music verwenden, natürlich nach höflicher Anfrage (könnte ich selbst übernehmen). Das sind recht vertraut klingende Songs aus Country und Rock inklusive guter Gesangsstimmen. Kann man sich anhören unter: http://www.pgmusic.com/artistperf.php?os=win

Was bringt ökonomisch und zeitlich der Einsatz von AI im Studio? Werde ich schneller? Kommt mehr Output beim rum? Im Falle von Phil Speisef stellt sich mir die Frage, für was ich da zahle? GUI mit AI Anbindung? THE_LIQUID hat mich nicht überzeugt. Ich hab das Programm einfach gebeten, „Hey, ich brauche einen dystopischen langen Hall im Stil von Bladerunner.“ Das Ergebnis klang „niedlich“.

@TobyB Ich denke, dass es noch deutlich zu früh ist, um das zu beurteilen. Aktuell ist es erst einmal ein Hype, der durch ChatGPT entstanden ist. KI in der Audiowelt gibt es schon länger. Meistens arbeitet sie im Hintergrund und wird gar nicht bemerkt.

Interessant wird KI dann, wenn sie den Arbeitsalltag beschleunigt und man sie selbst trainiert. So könnte ich mir zum Beispiel vorstellen, dass eine KI im Hintergrund der DAW arbeitet und vom Nutzer lernt. Es gibt ja doch bestimmte Dinge, die immer gleich laufen. So könnte die KI dann nach einer Weile zum Beispiel selbstständig immer auf bestimmten Spuren genutzte Insert-Effekte laden oder Aux-Effekte anlegen, dort die passenden Presets für den Rough Mix aufrufen, die Busse passend konfigurieren, Spuren benennen, gruppieren, schneiden usw. Natürlich kann man so etwas über ein Template lösen. Aber interessant wäre es dennoch, insbesondere, wenn auch bestimmte Aufgaben wie Gain Staging usw. im Anschluss von der KI überwacht würden. Wenn man der KI nur noch einen Ordner mit Audio-Files geben muss, um diese dann automatisch in der DAW anzulegen und man nach wenigen Sekunden „ready to go“ ist, wäre das in meinen Augen schon eine Erleichterung. Auch das nervige Erstellen von Stems könnte eine KI übernehmen. Samplen und loopen/mappen ist auch so eine Sache, die eine KI könnte. Braucht man sie? Natürlich nicht. Aber es könnte Dinge beschleunigen.

@TobyB Hast du mal das Valhalla Supermassive Plugin probiert? Bei den unzähligen Settings ist bestimmt etwas für dich dabei.

@ThreeoakBeatz , danke für den Tipp. Ich würde meinen selbst ohne Plugins habe ich genügend Reverbs hier. Also mehr als 15. Ich hab halt nur Phil Speisers THE_LIQUID 2 getestet und find das nicht gut.

KIs können keine Musik generieren. Das geht nur von Mensch zu Mensch. Wir könnten es zwar hören und uns daran gewöhnen aber es dringt nicht zu uns durch.

Weiteres von Mozilla:

Frage an Microsoft: Trainiert ihr eure KI mit unseren persönlichen Daten?

Wir haben 4 Jurist*innen, 3 Datenschutzexpert*innen und 2 Aktivist*innen beauftragt, den neuen Servicevertrag von Microsoft unter die Lupe zu nehmen. Wir fordern Microsoft auf Klartext zu reden, ob das Unternehmen persönliche Daten zu KI-Trainingszwecken einsetzt.

Ich glaube es ist nicht zu spät Linux zu installieren. Ist zwar nur ein Tropfen auf dem heißen Stein aber er tut nicht weh und geht mittlerweile ganz einfach.

Bei der Playback Erstellung stößt die KI aber schnell an ihre Grenzen. Meist steuert die Vocal Spur einen leichten Ducking Effekt, welcher auf alle anderen Spuren außer den Vox Spuren wirkt. Entfernt man jetzt den Gesang aus einem Song, bricht das Playback pegelmäßig immer etwas an den Stellen ein, an denen Vocals waren. Das kann die KI (noch) nicht wieder ausbügeln.