Die japanische Schrift besteht aus drei verschiedenen Zeichensystemen. Wichtig für uns ist nur Hiragana, das mit den „runden‟ Zeichen, das praktischerweise auch das Eingabesystem ist, mit dem in Japan auf dem Computer Text eingegeben wird. So auch hier.

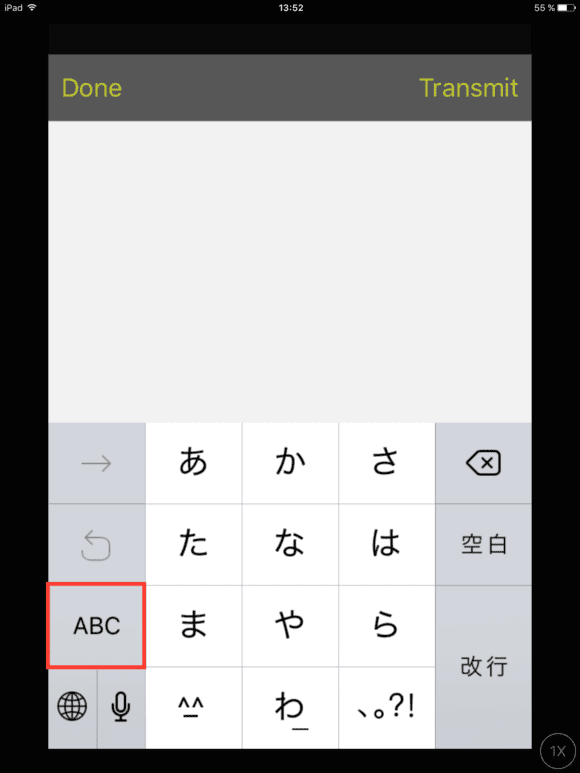

Als kleine Erleichterung brauchen wir uns aber noch nicht einmal mit Hiragana-Schriftzeichen herumzuschlagen, denn die japanische Tastatur verfügt auch über eine T9-Alphabet-Eingabe. Erinnert sich noch jemand an T9, als die Mobiltelefone nur Zehner-Tastaturen zur SMS-Eingabe hatten? Auf jeden Fall kann man so im alphabetischen System die Texte in Hiragana eingeben.

Eine wichtige Sache ist jedoch zu beachten. Da Japanisch ein Silbenschriftsystem ist und kein alphabetisches mit getrennte Konsonanten und Vokalen, muss eine Texteingabe der eigentlichen Aussprache des Wortes folgen und nicht dessen Schreibweise!!

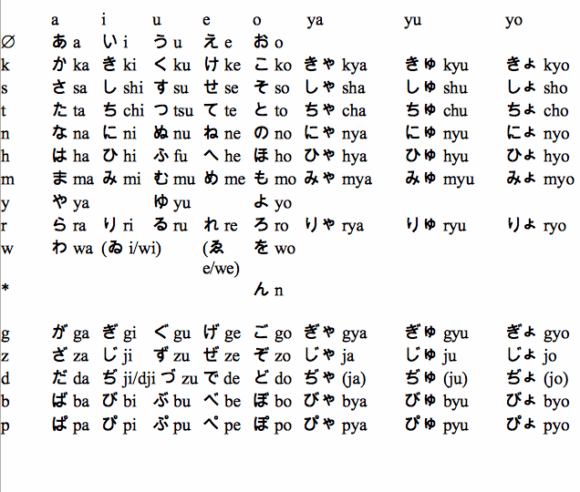

Zum Einstieg hier nun ein Überblick über die japanischen Silben. Wichtig dabei sind hauptsächlich die A, I, U, E, O Silbenreihen. Die drei letzten Y-Reihen sind erstmal vernachlässigbar.

Die Aussprache der japanischen Silben folgt so ziemlich der deutschen Sprechweise. Also ist z.B. ein „i‟ ein „i‟ und kein „ei‟ und ein „j‟ gleich ein „jott‟ und kein „jay‟, wie im Englischen usw. Ausnahme ist das „R, das zwischen einem sehr weichen „R‟ und einem „L‟ liegt. Rrrrrrrrrammstein-artige Aussprachen werden damit eher schwierig.

Auch große Beachtung sollte das „u“ erfahren, das in der japanischen Aussprache oft völlig erodiert wird. So wird aus einer „Ukulele“ eine “ ‚k’lele „oder einem „Markus“ schnell ein „Max“.

So ist die korrekte Ausprache des Pedals auch nicht „Hatsuuune“ sondern „haTs’ne“ mit einem extrem verschliffenen nur angedeuteten „u“.

Umgehend lässt sich das nur bedingt mit einem Diphtong, einem doppelt vorkommenden, aber getrennt ausprochenen Vokal, aus „uu“ wird lso nicht „u–“ sondern „u-u“. Am ehesten kommt man noch mit einem hinzugfügten „h“ hin.

Es sei auch darauf hingewiesen, das im Japanischen die Zweitsilben betont werden und nicht die Erstsilben (Wortanfang).

Hier heißt es Experimentieren.

Ei Gude :-)

ich habs Pedal gesehen und wusste du warst fleissig :-) Ich hab grade erst mit der Sprachsynthese im iDS-10 ein paar G-Syle Housetracks gemacht und hatte viel Spass damit, zumal das Ergebnis den Aufwand rechtfertigt. Hier sehe ich das ähnlich, ich meine sie/es soll ja keine Arien singen aber für vocaloide weibliche Bass und Leadfiguren a la Dalek, AYAY und was auch immer absolut zu gebrauchen. „Ich bin eine blasse Wäscherin“ ist arg speziell. Das letzte mal das ich sowas Spezielles hörte war vor 3 Jahren bei den BBC Proms zum 50 Geburtstag von Doctor Who.

https://www.youtube.com/watch?v=IHfkrxPsUpM

Aber wie dem auch sei, wenn es Goosebumps macht, ist das richtig :) aber ich halte ja auch die Synthline im Doctor Who für das wichtigste Sück Popmusik, das je geschrieben wurde ;-)

Vielen Dank für den sehr gelungenen Test!

Ich habe Miku seit rund einem Jahr und sie sogar schon live als „Leadsänger“ eingesetzt. Klang und Möglichkeiten faszinieren sehr, live ist Miku aber extrem schwierig zu handhaben. Mit einem Sequencer wäre es wohl einfacher, aber sonst ist es fast unmöglich, sie eine Textphrase so singen zu lassen, dass sie damit genau fertig ist, wenn auch die Melodie fertig ist. Und beim nächsten Ton startet sie ja nicht neu sondern singt einfach die nächste Silbe. Na ja, den Zuhöreren fällt das nicht auf. Da überwiegt der Überraschungseffekt und zwar sehr positiv …

@weinglas Haha, sehr cool!

Kann Dir auch sonst nur voll und ganz zustimmen.

Das Konzept ist sicher ausbaufähig. Einzige Möglichkeite Miku neu anfangen zu lassen ist kurz mal das Preset zu wechseln.

Ansonsten heißt es halt „go with the flow“.

:)

@weinglas Hallo Weinglas,

hast du auf deinem Youtube Channel Beispiele? Ich find Miku trotz fehlenden Midis schon interessant, sehe aber auch das es andere Geräte/Software gibt, die produktionstechnisch einfacher sind. Grüsse

@TobyB Hi Toby,

sorry dass ich erst jetzt antworte. Ich habe Deinen Kommentar iregendwie nicht mitgekriegt.

Hier ist ein Video von einem Liveauftritt in Rotterdam mit der Miku. Aber leider nur mit iPhone-Mikro:

https://www.youtube.com/watch?v=Li-P_aa68UE

@weinglas Hallo Wein,

sehr geil. Ich habe hier noch mobiles Recording Equipment u.a. einen Sony Minidisc HiMD für 4 Stunden WAV PCM bei 24/48 :-)

Danke für den Produkthinweis! Bei Thomann beschweren sich einige über die Latenz. Kann man das messen? Wäre man mit Midi Guitar in Kombination mit Plogues AlterEgo nicht schneller?

https://www.plogue.com/products/alterego/

@Chick Sangria Hi Christ,

für die Latenz und Tracking hab ich das entsprechende Audiobeispiel gemacht, ich glaube schneller und besser geht das mit dem Miku Stomp nicht.

MIDI-Gitarren Controller mit AlterEgo hat gut Chancen schneller zu sein, man mit MIDI-Interfaces durchaus unter 10ms Latenz wegkommt. Stimmstabiler auf alle Fälle, da die Tonhöhen ja schon in MIDI vorliegen.

M. :)

@Markus Schroeder Chick nicht Christ, blöde Autokorrektur.

@Markus Schroeder Danke! Christ ist gut. Hatte den Test übersehen. Klingt nach sehr viel und daher live nicht tight benutzbar.

@Chick Sangria Nein, Tight ist nicht die Stärke des Miku Stomp, aber wie auch Weinglas weiter oben geschrieben hat: Überraschungen schon.

Aber das muss man halt auch mögen.

:)

@Chick Sangria Sorry, heute ist anscheinend Legastheniker Tag bei mir.

Für die Latenz und das Tracking hab ich das entsprechende Audiobeispiel gemacht. Ich glaube schneller und genauer geht das mit dem Miku Stomp nicht.

Mit MIDI-Controllern und AlterEgo hat man sicher gute Chancen schneller zu sein. Mit MIDI-Interfaces bekommt man ja durchaus unter 10ms Latenz hin. Stimmstabiler ist es auf auf alle Fälle, da die Tonhöhen ja schon in MIDI vorliegen und nicht getrackt werden müssen.

Oder meinst Du das MIDI-Tracking einer normalen Gitarre? Dann kommt es wieder auf die Latenz und Genauigkeit des Gitarren-Trackers an.

Ich denke, sobald Noten/ Frequenzen getrackt werden müssen, geben sich die Methoden nicht mehr viel.

Grüße,

M. :)

bin mir gerade nicht ganz sicher: soll bei den audiobeispielen irgendetwas verständliches dabei sein? also ich versteh da irgendwie nur bahnhof…

@dilux Das war bestimmt japanisch, ich hab auch nix verstanden

Auf Sprachverständlichkeit hab ich bei den Demos keinen Wert gelegt.

:)

@Markus Schroeder Hallo,

dazu gibts hier Gelegenheit. ;-)

https://youtu.be/rL5YKZ9ecpg

Nach dem Breakbeat-Intro hab ich mein Knicklicht gesucht. :)

Die Japsen sind schon sehr speziell, so wie dieses Gerät zeigt. Ich für mich finde es völlig unbrauchbar, da stellen sich mir die Nackenhaare.

http://i.imgur.com/DZ0de04.jpg

Guten tag ich habe das miku stomp kürzlich neu gekauft und möchte auch gerne wissen wie das genau geht? Z.b kann man komplette japanische lieder wie shinkegi no kyojin attack on titan und wie genau funktioniert das mit iphone zu miku stomp also mit einem aux stecker oder reicht das signal direkt vom iphone ins gitarren pickup lg brian

@Miku chan Hallo Miku chan,

Du kannst den Test eingeben oder aus einer anderen App wie Text oder Email per copy and paste übertragen.

Allerdings sollte der Test noch vorher in in Silben formatiert werden, denn mit der jeder Auslösung rückt der Parser eine Silber weiter. Da musst Du etwas experimentieren damit die Aussprache und das Auslösen halbwegs verständlich ist.

Dann verbindest Du das iPhone / iPad mit dem Kopfhörerausgang mit dem Klinkeneingang am Pedal.

Wenn Dein iPhone / iPad nur einen Lightning-Ausgang hast, brauchtst Du noch ein Adapterkabel auf analoge 3,5mm Klinke. Lightning-Kopfhöreradapter gibt z.B. von Apple oder Griffin.

Um den Text in das Korg Miku Stomp zu übertragen, verbindet man den Kopfhörerausgang des iPads mit dem Eingang des Pedals und hälst den Effektschalter solange gedrückt, bis die gelbe und die rote LED anfangen zu blinken. Das Pedal schaltet nach der Übertragung automatisch zurück in den normalen Betriebszustand.

Ich hoffe das hilft Dir weiter,

greetz,

M. :)