Grundlagen des Mastering

Gleich vorab: Dieser Artikel richtet sich an Einsteiger – als weiterführende Lektüre empfehlen wir den AMAZONA.de-Dreiteiler MASTERING von Toningenieur Armin Bauer.

Grundlagen des Mastering

Im Folgenden wird exemplarisch der Ablauf eines Masterings beschrieben. Diese Arbeitsanweisungen sind jedoch nur als Vorschlag und nicht als absolute Anleitung anzusehen. Einige Tipps können sicherlich sehr oft helfen oder sind auf jeden Fall wie beschrieben durchzuführen (technische Bearbeitung wie Normalisieren, DC-Offset etc), andere hingegen nur bedingt, da es verschiedene Möglichkeiten gibt, je nach Geschmack und Vorliebe (Routing von EQ und Kompressor etc). Letztendlich liegt es im Ermessen des Mastering-Engineers, den richtigen Weg zu finden.

Verwendet am besten für diesen Workshop einen Mix, z.B. mit einer E-Piano-Spur, Drumloop, einigen Percussions und Bass. Von Vorteil wäre, wenn nicht nur Plug-Ins verwendet wurden, sondern z.B. auch eine echte Gitarre oder eine Stimme aufgenommen wurde. Damit hat das Ausgangsmaterial noch eine Menge Dynamik und geringe Lautheit.

Mastering – Erste Arbeitsschritte

Die Audiodatei sollte im digitalen Format auf dem Rechner vorliegen. Zunächst diese kopieren und die folgenden Arbeitsschritte mit der Kopie durchführen.

Die kopierte Audiodatei in die Bitrate konvertieren, mit der das benutzte Programm intern arbeitet (z.B. bei Wavelab 32 Bit). Dies ist vor allem wichtig bei Fades und filigraner Musik wie Jazz, Klassik etc.) Noch kein Fades machen! DC-Offset entfernen. Die sogenannten Gleichspannungsanteile sind heute dank guter Wandlerqualität selten geworden. Trotzdem sollte dieser Schritt nicht fehlen. Normalisieren: die höchste Pegelspitze (Peak) auf ca. –0.3db bis –0.4db normalisieren, nicht höher, da sonst im restlichen Mastering-Prozess nicht genügend Headroom vorhanden ist.

Denoising:

Entweder mit Noise Print oder mit Noise Reduction Software; sofern nötig, Declicking: mit Software oder in schwierigen Fällen mit dem Stift Klicks und Knackser entfernen. Braucht meistens auch nur angewendete zu werden, wenn von älteren Schallplatten Material überspielt wurde. Limiting: es ist durchaus sinnvoll, schon vor der weiteren Dynamikbearbeitung einen Limiter einzusetzen, um musikalisch nicht relevante Peaks zu limitieren und so schon im Vorfeld 3-4 dB mehr an Pegel zu erreichen. Dabei den Threshold so einstellen, dass wirklich nur die höchsten Pegelspitzen bearbeitet werden.

EQing: Equalizer wenn möglich so einsetzen, dass Frequenzen abgesenkt werden. Anhebungen nur in Notfällen und sehr sparsam durchführen! Eine Vorgehensweise bezüglich Absenken „mulmender“ Frequenzbereiche ist, Frequenzen im Grundtonbereich des Songs schmalbandig leicht abzusenken! Im Falle unseres Beispielsongs wurde ein Lo Cut bei 30 Hz gesetzt (darunter spielen sich eh keine relevanten Informationen mehr ab), der Bassbereich bei 67 Hz schmalbandig angehoben (+4dB) und bei 130 Hz etwas abgesenkt. So konnte der Bassbereich etwas „entmulmt“ werden, bedingt durch Überlagerung und daraus entstehender Resonanz von Bass Drum und Bass. Mit einem Hi Shelf bei 10 kHz wurde der Höhenbereich etwas aufgefrischt 8+4dB), ein Exciter oder Enhancer ist kaum notwendig

A/B Vergleich:

Eine Referenzproduktion auf den gleichen Lautsprechersystemen zur klanglichen Orientierung probehören. Dynamics anwenden: Kompressor oder ähnliche Dynamikeffekte anwenden; hierfür wurde ein Multibandkompressor verwendet, um alle Frequenzbereiche leicht zu komprimieren.

A/B Vergleich probehören:

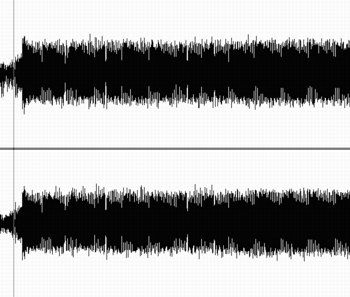

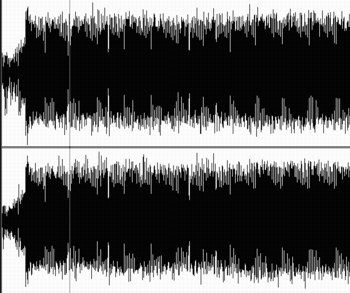

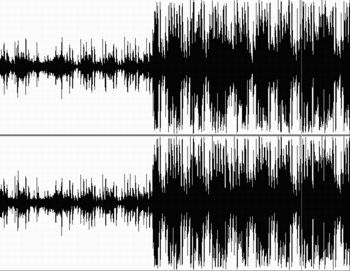

Den Track auf anderen Lautsprecher probehören. Psychoakustische Effekte anwenden: Exiter, Enhancer, Stereobasisverbreiterung oder ähnliche Klangverbesserer anwenden; da der Einsatz gerade von stereobasisverbreiternden Effekten immer eine heikle Angelegenheit ist und der Song schon aufgrund seines Mixes relativ „breit“ klingt, wurde auf den Einsatz von solchen Effekten verzichtet. Der Obertonbereich klingt auch recht präsent, ein Exciter ist daher auch nicht unbedingt notwendig. Limitieren: mit dem Limiter die Dynamik begrenzen; auf dem Bild zu erkennen: der deutlich höhere RMS-Pegel des Gesamtsignals (-1dB)! Die Reihenfolge von Limiter, EQ, Kompressor ist beliebig und kann unterschiedliche Ergebnisse bringen. Letztendlich sollte am Schluss der Signalkette jedoch ein Limiter sein, um einem Übersteuern vorzubeugen! In unserem Fall wurde ein Loudness Maximizer eingesetzt, was bei Produktionen mit überwiedegn akustischen Instrumenten jedoch nicht immer gut klingen muss. Hier sollte man ein klein bisschen Leben erhalten! In unserem Fall bewirkte der Einsatz des Loudness Maximizers, dass Snare und Hi Hat plötzlich recht laut und scharf klangen. Ein kurzes Nachregeln des EQs bei 3,5 kHz 8-3,5dB) brachte Besserung.

Den fertigen Track normalisieren:

Der fertige Song sollte nochmals normalisiert werden, jedoch auch nur-0,4- 0,2 dB, insofern das nach der Dynamikbearbeitung noch nötig ist. Sample Rate/ Bit Rate konvertieren und dem verwendeten Master anpassen. Soll der Song am Ende auf eine CD-R gebrannt werden, empfiehlt sich zuvor eine Konvertierung in 44,1 kHz/ 16Bit. Ist ein hochwertiger Dithering-Algorithmus (wie z.B. Apogee UV22) verfügbar, diesen unbeding einschalten.

Song abspeichern:

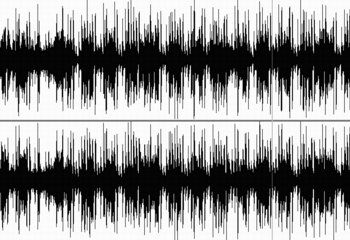

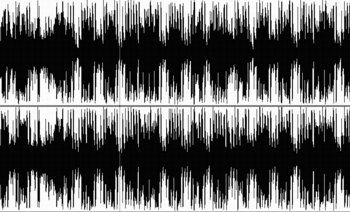

Eine sinnvolle Benennung des Tracks ist vorteilhaft, um den Überblick zu behalten A/B-Vergleich mit dem Ausgangsmaterial: dazu die gewonnene Lautheit wieder reduzieren (Leveler am Ende der Bearbeitungskette), damit beide Versionen mit gleicher Lautstärke bewertet werden können, um evtl. Klangveränderungen besser wahrnehmen zu können. Diesen A/B-Vergleich auch nach jedem klang- bzw. dynamikbearbeitendem Schritt (Ab 5.) wiederholen. Im folgenden Audiobeispiel wurde das Ausgangsmaterial mit dem Endergebnis zusammengeschnitten. Achtung, es wird nach ca. 8 Sekunden recht laut!

Hi Max,

das ist mal eine gelungene Basis Einführung in das Thema. Leider sind die Sounds hinten runter gefallen, lassen sich die noch nachträglich einfügen?

Ein Punkt wäre noch die Panoramaverteilung, auch Frequenz abgestimmt, da lässt sich auch noch viel machen.

Danke dir auch für die Erwähnung meiner Workshops. Der „Toningenieur“ ist aber etwas hoch gegriffen, wir dürfen es gerne beim Tontechniker mit reichlich Erfahrung belassen :-)

Grüße Armin

Ich finde diese Konzentrierung auf Mastering überdenkenswert.

Wer nicht Multitracks mischen kann, kann meiner Meinung nach auch nicht mastern.

Es entsteht der Eindruck, Mastering ist das Nonplusultra, dabei bin ich der Meinung, das erstmal ein vernünftiger Mix entstehen sollte.

@vssmnn Ohne Frage ist das Mixing sehr sehr wichtig. Als Mastering Engineer hat man mit der Veredelung (nicht nur Lautheit!) zu tun und das ist der finale Schritt zu einem guten Klang. Da freut sich der ME, wenn der Mix schon sehr gut ist. Dann sind die Eingriffe homöopathisch, aber dennoch sinnvoll und notwendig.

Da man dafür die Ohren braucht, sind diese Online-Master einfach kaum zu gebrauchen. Es sei denn, man will einfach nur etwas Lautheit, dann funktioniert das natürlich auch. Professionelles Niveau lässt sich damit nicht erreichen und macht einen guten Mix womöglich sogar kaputt.

@vssmnn Sind wirklich zwei paar Stiefel. Ein guter Mix macht es dem Mastering-Ingenieur natürlich leichter, oft werden aber die Aufnahmen und Mixes in verschiedenen Studios gemacht und müssen angepasst werden.

Oder aber, wie bei meinem Turmschatten Master, völlig unterschiedliche Aufnahmen, die in einen stimmigen Kontext gesetzt werden sollen.

Das ist sehr wichtig sogar. Dadurch verhindert man die Übersteuerung bei der Bearbeitung.

@Marco Korda Jede DAW oder Audiobearbeitungs-Software arbeitet heutzutage intern mit 32bit floating point (manche auch mit 64)., d.h. jeglicher Audioprozess, den man auf eine 16bit-Datei anwendet, tut dies in 32bit und konvertiert somit auch die Daten der Datei “on the fly” dorthin, selbst ein simples anpassen der Lautstärke. Übersteuerung ist somit kein Problem. Natürlich muss man am Ende, wenn man zB wieder in 16bit speichern will, aufpassen, dass der Pegel nicht über 0dBFS geht und dann auch dithern.

@janschneider Einfach intern auf 32bit FP zu wandeln ändert klanglich nichts. Es ist lediglich das anhängen leerer Bits. Durch Offline-Processing auf 32bit aber sieht dies schon anders aus, das kann je nach Arbeitsweise einen Performancegewinn darstellen. Grundsätzlich spricht nichts dagegen 16bit-Dateien zu verwenden, dennoch gilt: je höher, desto besser für das Mastering.

Und zum Dithern: hm, ja, da gibt es diverse und kontroverse Diskussionen drüber. Da gibt es quasi philosophische Abhandlungen zu :-D

@Marco Korda Tschuldigung, aber das sind jetzt sehr unlogische Aussagen:

„Intern auf 32bit wandeln ändert klanglich nichts, … durch offline-Processing aber sieht das schon anders aus, das kann … einen Performancegewinn darstellen“

Wo ist da der Zusammenhang?

Klanglich ändert sich definitiv nichts, ob man jetzt von 16 nach 32 bit online oder offline wandelt (wenn doch, würde ich die Software wechseln). Der Performancegewinn mag evtl messbar sein, ich bezweifle aber stark, dass der bei den heutigen CPUs merkbar ist. Unabhängig von der Arbeitsweise. Speziell beim, Mastern, wo man keine 300 Spuren hat.

„ dennoch gilt: je höher, desto besser für das Mastering.“

Warum? Mir fiele nur ein organisatorischer Grund ein: man will keine Tracks bekommen, die einen Limiter auf der Summe haben, aber sie sollen natürlich auch nicht clippen. Da ist es natürlich einfacher zu sagen: bitte liefert mir Files in 32bit ungedithert. Klar, ist am sichersten, würde ich auch so machen.

Hat aber auch nichts damit zu tun, dass der von xmario zitierte Satz so nicht zwangsläufig richtig ist ([besserwisser]und auch terminologisch falsch, „Bitrate“ müsste „Bittiefe“ oder „Auflösung heißen [/besserwisser])

Dithern ist natürlich eine schönes Thema, wo sich die Goldohren in den Foren dran abarbeiten können… :) der pragmatische Ansatz ist einfach „schaden tuts nichts“…

@janschneider Anscheinend arbeiten alle anders, das ist ja auch okay. Für die Beantwortung der Frage muss der Taschenrechner rausgeholt werden. In nur kurzen Worten: Bei 16bit hast du 2 hoch 16 Dynamikstufen, bei 24 bit 2 hoch 24 usf. Der Vorteil liegt daher auf der Hand. Mit 16bit kann man natürlich auch gut arbeiten, aber ich komme schneller in die Übersteuerung beim Bearbeiten. (Kurzversion, PM für längere Diskussion)

@janschneider Leute mit sehr esoterischem Gehör mögen argumentieren: wenn ich von 16 nach 24 bit gehe (die ersten Beispiele Fixkomma), dann hänge ich wie der Autor sagt erstmal Nullen an. Ich kann dabei drüber nachdenken (!), daß ich ja was erneut gegen Quantifizierungsverzerrung tun kann und ein Rauschen draufleg (vulgo: Dither), wobei ich das, wenn ich von 16bit komme, für vollkommen nutzlos halte.

Falls aber jemand zuverlässig feststellt, das klingt besser – dann isses für den Menschen mit den Superohren freilich sinnvoll, das offline zu machen, weil dann kann ich mir den esoterischen Dither/Noiseshaper meiner Wahl raussuchen.

Ansonsten war für mich in den ganzen rechnerbasierten Sachen die Einführung von Fließkommaaudio ein wunderbarer Tag, weil ich mir da (außer aus praktischen Gründen) übers gain staging keine Gedanken mehr machen muß. Soll heißen: Normalisieren von Audiodateien laß ich gleich ganz bleiben, weil zusätzlicher Bearbeitungsschritt und Rundungsfehler. Ich werd‘ sowieso irgendwann was am Pegel machen, und das mach‘ ich genau einmal, und bevorzugt an der Stelle, wos für mich am praktischsten ist (und das sind bei mir nie nicht die Eingangsdateien).