Die perfekte Mix-Balance

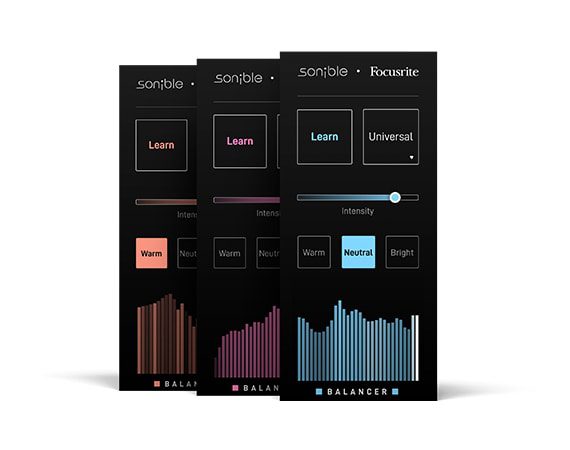

Von Zeit zu Zeit berichten wir hier bei AMAZONA.de von Software-Produkten, die mit Hilfe von künstlicher Intelligenz für bessere Kompressionen, Equalizing oder Mixe sorgen. Das Unternehmen Sonible hat uns dabei schon des Öfteren überzeugt, u. a. mit dem Smart Comp. In Zusammenarbeit mit Focusrite ist nun der Balancer entstanden.

Basis des Balancer Plugins ist die Smart-Engine von Sonible. Diese analysiert das eingehende Material und setzt auf Basis von diversen Algorithmen und Filtern die passenden Einstellungen. „Passend“ liegt natürlich im Auge (Ohr) des Betrachters, so dass das Plugin diverse Grundeinstellungen und Presets erlaubt. Was genau dann im Hintergrund passiert, bleibt natürlich Geheimnis von Sonible. Hier ein Tutorial, das die Arbeitsweise von Sonible/Focusrite Balancer näher bringt:

Sie sehen gerade einen Platzhalterinhalt von YouTube. Um auf den eigentlichen Inhalt zuzugreifen, klicken Sie auf die Schaltfläche unten. Bitte beachten Sie, dass dabei Daten an Drittanbieter weitergegeben werden.

Die Bedienung des Plugins scheint aufgrund der wenigen Bedienelemente natürlich kinderleicht. Man entscheidet sich lediglich zwischen den Presets Warm, Neutral und Bright, dreht am Intensity-Regler und bestimmt somit, wie groß die Einflussnahme des Balancers ist, den Rest erledigt das Plugin. Wie auch schon beim Soundtheory Gullfoss scheint hier die Devise zu gelten: Weniger ist mehr, denn im Gulfoss-Test zeigte sich, dass ein mäßiger Einsatz des Plugins in der Regel immer zu Verbesserungen des Klangs führte, während ein heftigerer Einsatz oft zu harschen Ergebnissen führt.

Das Balancer Plugin lässt sich im AU-, VST- und AAX-Format einsetzen und unterstützt Abtastraten von 44,1 bis 192 kHz.

Über die Website des Herstellers ist Sonible Balancer ab sofort, aber nur bis zum 4. Mai 2020 erhältlich. Der Preis: kostenlos. Ausprobieren ist da fast schon Pflicht. User des Focusrite Plugin Collectives sollten bereits Zugang zum Balancer bekommen haben.

Musste schon bei vielen „Autopilot“-Plugins feststellen, dass die in den Werbevideos verwendeten Audiofiles immer bestens zum angepriesenen Plugin passen, und beim Testen dann meist die Ernüchterung kam. Werde dieses Plugin aber definitiv auch mal ausprobieren. Rein aus Interesse. Danke für den Hinweis! :-)

@bbr Also ich würde sagen die benutzen meistens ziemlich gute mixdowns welche natürlich länger brauchen bis sie schlecht klingen beim ausprobieren. Guter mixdown-> (egal welchen) compressor auf 2-3db reduction=schon kann man sagen „mensch was für ein sauberer compressor“ :-) Ich habe es ausprobiert. Kann manchmal richtung beindruckend klingen aber andere male macht es ein tickchen zu viel des guten egal wieviel „Wet“ man reduziert. Also die lösung für alles ist es nicht aber für Null Euro ist es gold wert.

War vor ein paar Jahren mal im Rahmen einer Betriebsführung für Studenten in der Firma. Da haben sie die Technologie dahinter zumindest grob beschrieben. Damals ging es allerdings noch um den frei:raum. Ich schätze, dass das Grundprinzip noch immer ähnlich sind. Sie verwenden ein Wahrnehmungsmodell für Klang, welches es erlaubt, dass die Software bestimmte Eigenschaften (Features) eines Klanges sehr ähnlich wahrnimmt, wie Menschen es würden. Im Fall von frei:raum ist das dann zum Beispiel, welche Anteile eines Audiosignals Direktschall und welches Raumreflektionen sind. Dabei gibt es bestimmte technische Einschränkungen – frühe Early Reflections können nicht vom Direktschall separiert werden. Zurück zum Thema ausgewogener Klang. Ein Smart-EQ war auch schon im frei:raum enthalten. Das in diesem Fall benötigte Feature von „Ausgewogenheit“ eines Klanges lässt sich mit Sicherheit auch irgendwie erkennen.

So weit ich mich erinnere, war das Wahrnehmungsmodell nicht einfach nur ein „billiges“ Machine-Learning-Modell, sondern beruht auf Erkenntnissen aus der Psychoakustik und Wissen über die Funktionsweise des menschlichen Gehörs. Das psychoakustische Wissen ist zum Beispiel deshalb interessant, weil sich dann aus dem Audiosignal vor der eigentlichen Analyse alle redundanten Informationen entfernen lassen, die man eh nicht wahrnimmt (z.B. durch Maskierungseffekte).