Soziokulturelle Perspektiven werden auch im Panel „Music as a Voice in Society“ beleuchtet. Zu Gast sind hier der britische Rapper, Autor und Dozent Kingslee James Daley, auch bekannt unter dem Künstlernamen Akala, der derzeit in Berlin residierende Künstler und Dozent Mat Dryhurst sowie der ägyptische Musikethnologe und Mitbegründer des Nile Project Mina Girgis. Beim Nile Project handelt es sich um ein 2011 initiiertes interkulturelles Musikprojekt, an dem Musiker aus allen elf an den Nil angrenzenden Ländern beteiligt sind. Die Kollaboration wurde unter anderem deshalb ins Leben gerufen, weil es nicht nur den Durchschnittseuropäern in der Regel schwerfallen dürfte, diese Länder aufzuzählen (dies sind Ägypten, die Republik Sudan, die Republik Südsudan, Äthiopien, Uganda, die Demokratische Republik Kongo, Kenia, Tansania, Ruanda, Burundi und Eritrea), geschweige denn, etwas über sämtliche damit verbundene Kulturen auszusagen.

Laut Girgis ist die Lage am Nil nicht anders, was zur Folge hat, dass sich die Nachbarn dieses riesigen Ökosystems, in dem die Wasser-, Elektrizitäts- und Nahrungszugänge ungleich verteilt sind, fremd sind. Geläufig kann allein Ägypten für sich verbuchen, mit dem Nil assoziiert zu werden. Das Nile Project dient vor diesem Hintergrund nicht nur einem fortwährenden Prozess des einander Kennenlernens, etwa durch den Austausch traditioneller Musikinstrumente unter den Mitwirkenden. Durch das Projekt soll auch ein Paradigmenwechsel eingeleitet werden, der den jeweils kulturellen Besonderheiten dieser Region Rechnung trägt und einseitige Narrative über alles infrage stellt, was für gewöhnlich mit dem Nil verbunden oder aber diesbezüglich in den Schulen der Anrainersaaten gelehrt wird. Das transformative Potential von Musikprojekten betont auch Daley, der in diesem Rahmen auf die Überwindung eurozentrischer Geschichtsschreibung und der immer noch durch Lehrpläne vermittelten Stereotype abzielt. In seinen eigenen Arbeiten befasst er sich daher mit der Kodierung kultureller Ideologien.

Dazu zählt auch die Auseinandersetzung mit dem Potential dessen, was Dryhurst den symbolischen Gestus von Kunstwerken nennt. Als überaus bekanntes Beispiel wird hier Jimi Hendrix’ „Star-Spangled Banner“ genannt, in dem die amerikanische Nationalhymne vor dem Hintergrund des Vietnamkriegs in einem Feedback-Donner versinkt. Dryhurst weist jedoch zugleich darauf hin, dass das subversive Potential solcher symbolischen Gesten keineswegs absolut und stets kontextabhängig bleibe, wovon allein die Verwendung von noch in den 1960er Jahren als revolutionär geltenden Songs in heutigen Autowerbespots zeuge. Um letzteres weiterhin kritisch reflektieren zu können, falle auch den Künsten in Zukunft eine Bildungs- und Aufklärungsrolle zu. Angesichts schrumpfender Fördertöpfe für kulturelle Projekte sowie der prekären Lage von Musikern besteht an diesem Punkt kein Anlass zur Euphorie. Dennoch verweist Dryhurst optimistisch auf prinzipientreue Künstler – er hat hier insbesondere die Hardcore-Szene und Bands wie Fugazi im Blick –, erschwingliche Labels und die öffentlichen Musikschulprogramme in Chicago, an denen sich unter anderem der Rapper Add-2 beteiligt und die dazu dienen, Jugendliche von der Straße zu holen und ihnen eine Perspektive zu geben.

- Moderator Ed Williams, Akala, The Nile Project und Mat Dryhurst.

- Frances Morgan im Gespräch mit Musiker_innen des Nile Project.

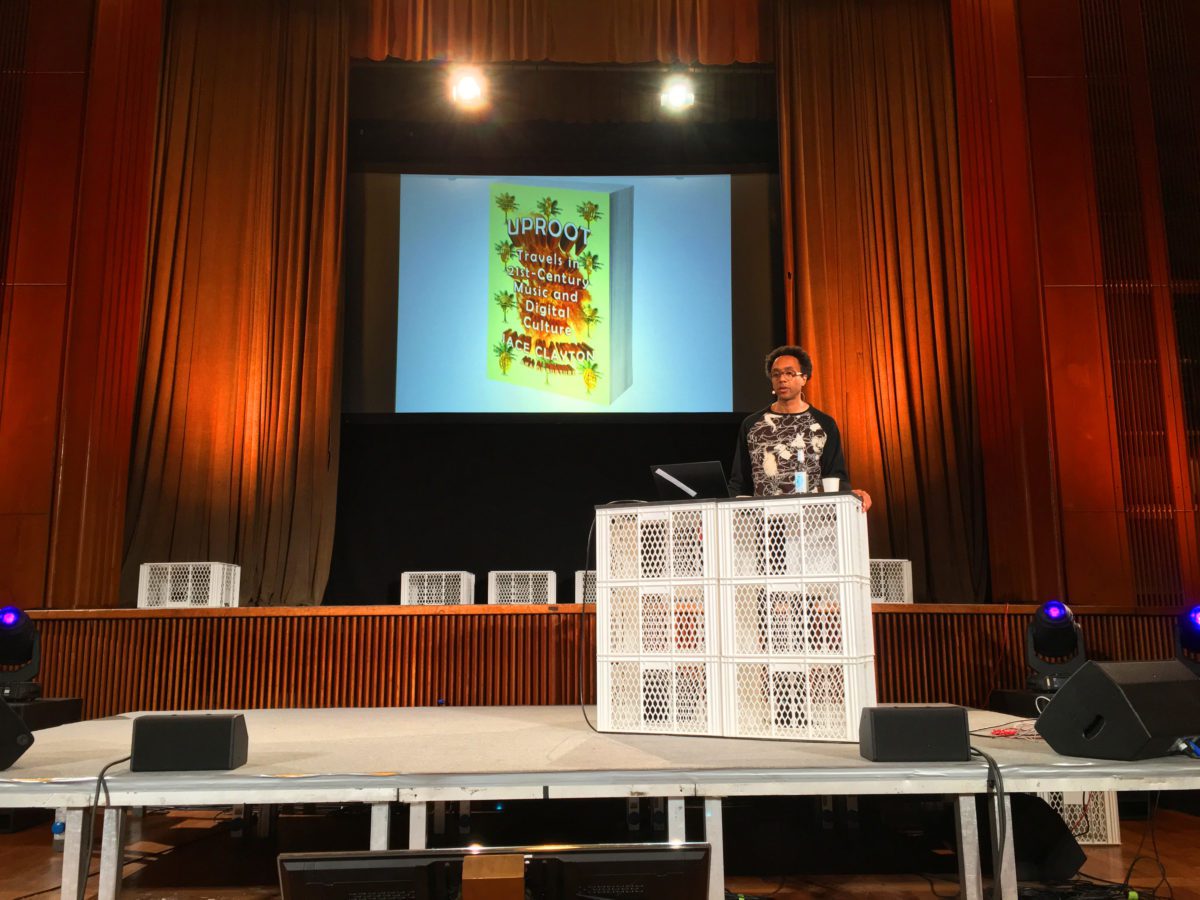

Der Frage, wie sich Musik zum gegenwärtigen gesellschaftlichen Klima verhält, geht in dem Vortrag „Uproot: Global Travels in the 21st Century“ auch der New Yorker DJ Jace Clayton (auch bekannt unter dem Namen DJ /rupture) nach, wenngleich er auch zu ernüchternden Schlüssen kommt. Claytons Präsentation, dessen Titel auf sein kürzlich erschienenes Buch zurückgeht, basiert im Wesentlichen auf dem im Laufe seiner DJ-Karriere erfahrenen technologischen Wandel. Er nimmt dies zum Anlass zu untersuchen, welche Auswirkungen es hat, wenn der Computer das Hauptinstrument ist.

Hierzu führt er den Begriff „World Music 2.0“ ein, der nichts mit der in den 1980er Jahren von Plattenfirmen zu Marketingzwecken aufgegriffenen Bezeichnung zu tun hat. Vielmehr zählt Clayton hierzu als Bedingung das globale Musiknetzwerk, in dem Plattformen wie YouTube eine gesteigerte Bedeutung zukommt und Online-Interaktion tonangebend ist. Als maßgebliche Akteure treten hier vor allem Nutzer und informelle Musiker in Erscheinung, die mit oftmals geringsten Mitteln Remixe oder Fan-Videos erstellen und dadurch im Grunde eine neue Form der Volksmusik für die digitale Ära schaffen. Kennzeichnend seien die ständige Gleichzeitigkeit von jedweder Information, die völlige Abwesenheit lokalspezifischer Genre-Bezüge (wie etwa der Liverpool-Sound, der Manchester-Sound, der Sheffield-Sound, etc.) und schließlich das Handeln außerhalb der Strukturen von Labels und Plattenfirmen.

Im Zusammenhang gesteigerter Informationsflüsse wendet sich Clayton dem Medium zu, das bereits vor Internetzeiten gewohnt war, weiter reisen zu können als es den meisten Menschen physisch möglich war: dem Geld. Genauer gesagt geht es ihm um die Rolle des Geldes in dem Genre, das sich seit spätestens den 2000ern obsessiv damit befasste: Rap. Anhand einer Lektüre verschiedener Rap-Lyrics der vergangenen Jahre, stellt Clayton fest, dass sich das Geld darin von einem Prahlgegenstand in einen Anlass für Resignation verwandelt hat. So heißt es in den zuletzt zitierten Lyrics des Songs „Swang“ von Rae Sremmurd: „When the money talks, what is there to say?“ („Was gibt es noch zu sagen, wenn das Geld spricht?“) Die zunehmende Beschleunigung von Kapital – und dazu zählt letztlich auch der Informationsfluss – führe, so die These, zur Erschöpfung und Sprachlosigkeit.

Clayton macht dies vor allem daran fest, das Texte neben Samples eine zunehmend geringere Rolle spielen und Zeichnen jenseits dessen in den Vordergrund rücken, also beispielsweise das Sound Design an sich sowie die Kopräsenz verschiedener Gesangsarten, unter anderem unterstützt durch Autotune. Daraus resultiere der passende Klangteppich für eine Realität, in der man in erster Linie als Hyper-Netzwerker und Über-Performer tätig sei, jedoch jegliche Autonomie verloren habe, da es kein Außerhalb dieses Systems gebe – trägt man es doch stets in seinem Mobiltelefon umher. Um seinen Vortrag nicht in einem allzu pessimistischen Ton enden zu lassen, fügt Clayton jedoch an, dass man trotz gesteigerter Abhängigkeitsverhältnisse weiterhin die Freiheit habe zu entscheiden mit wem man kollaborieren wolle.

Um die Bedeutung von geeigneten Ansprechpartnern geht es schließlich in dem Panel „Finding Balance: Conversations on Musicianship and Mental Health“. Christine Brown, Mitarbeiterin der britischen Wohltätigkeitsorganisation Help Musicians UK, trifft sich hier zu einem Gespräch mit dem australischen DJ und Produzenten Rick Bull, besser bekannt unter dem Namen Deepchild, der Produzentin und Komponistin Emika und dem Hip-Hop-inspirierten Jason Chung, der unter dem Pseudonym Nosaj Thing produziert. Brown stellt zunächst die von ihrer Organisation initiierte Kampagne „Music minds matter“ („Musikergemüter sind von Bedeutung“) vor. Deren Ziel besteht darin, dem Phänomen gewahr zu werden, dass ein Großteil von Musikern unter Depressionen und Angstzuständen leidet. Überdies geht damit die Einrichtung einer Telefonseelsorge einher, die betroffene Musiker an entsprechende Hilfseinrichtungen vermittelt. Brown führt aus, dass die Wahrscheinlichkeit von Depressionen betroffen zu sein unter denjenigen Menschen, die in der Musikbranche tätig sind, dreimal höher sei als der statistische Durchschnittswert. Dies liege nicht zuletzt an den oftmals prekären Lebensverhältnissen und den daraus resultierenden Existenzängsten.

Nach einem offenen Gespräch über die Depressionserfahrungen der drei Gäste weist Emika darauf hin, dass das Phänomen nicht nur unter Musikern zunehmend diskutiert, sondern als mittlerweile weitverbreitetes gesellschaftliches Symptom wahrgenommen werde. Was jedoch vor allem die Kreativbranche dafür anfällig mache, seien gesteigerte Formen der Selbstvermarktung, die Erwartungshaltung auf sämtlichen medialen Plattformen rund um die Uhr präsent sein zu müssen und die obsessive Messung von Followern und Likes. Rick Bull fügt hinzu, das auch ökonomische Gründe maßgeblich seien, die er als Kehrseite zunehmender Demokratisierungsprozesse begreift: Durch die Tatsache, dass immer mehr User scheinbar voraussetzungslos Musik produzieren können, wurde nicht nur der ‘Content’ sowie jedwede Kreativarbeit entwertet, sondern auch die kreative Mittelklasse abgeschafft.

Die Entwertung sämtlichen Inhalts mindere überdies die Wirkung subversiver Absichten, während eine zunehmende Fetischisierung von Individualismus solidarische Entwicklungen hemme. Dass der Musikindustrie in dieser Hinsicht nicht mehr zu helfen sei, geben alle drei Gäste zu Protokoll, weshalb es in erster Linie wichtig erscheine, sich mit individuellen Taktiken über Wasser zu halten. Für Emika gehören dazu eine notwendige Entschleunigung, eine nur noch eingeschränkte Nutzung von Social-Media-Plattformen und ein Maß an Entfremdung, das eindeutig zwischen ihr als Kunst- und Privatperson trennt. Bull entschloss sich hingegen für den Rückzug aus den Kreativmetropolen Berlin und London und schlägt vor, mit Gleichgesinnten zu kollaborieren, während Chung für Meditation und eine Rückbesinnung auf das plädiert, was einen ursprünglich künstlerisch angetrieben hat.

Science-Fiction ist jetzt

Szenenwechsel: Auf einer Konferenz für Musikschaffende dürfen natürlich Diskussionen über gegenwärtige technologische Fragen und Ansätze nicht fehlen. Dahingehend eröffnet wird Loop mit dem Panel „A Sense of Touch: Haptics in New Musical Instruments“. Eingeladen sind hierfür Lauren Sarah Hayes (Assistenzprofessorin für Klangstudien in der Fakultät für Kunst und Medientechnologie der Arizona State University und Mitglied des New BBC Radiophonic Workshop) und Alexandros Kontogeorgakopoulos (Dozent der Fakultät für Kunst und Gestaltung an der Cardiff Metropolitan University).

Hayes’ Ausgangspunkt ist die Frage, wie man bei vermehrter Nutzung von virtuellen Klangerzeugern das haptische Erlebnis erfahrbar machen kann, das man mit akustischen Instrumenten verbindet. In ihren Arbeiten geht es folglich darum, die Diskrepanz zwischen den derzeit möglichen digitalen Klangpotentialen und dem physischen Bezug zu den daraus resultierenden klanglichen Erlebnissen zu überbrücken. Zu diesem Zweck entwickelt sie sensorische Schnittstellen für den Körper, die akustische Signale in ein physisches Feedback übersetzen, beispielsweise durch Vibrationen.

Das so zustande kommende audio-haptische Erlebnis kann spielenden Musikern nicht nur ein unmittelbareres Verhältnis zu virtuell erzeugten Klängen ermöglichen, sondern birgt auch strategische Potentiale. So etwa durch den Einsatz haptischer Click Tracks, die es nicht länger notwendig machen, dass Musiker einander ansehen müssen, um gemeinsam im Takt zu bleiben. Darüber hinaus könne auch mit dem Verhältnis zwischen Klang und haptischem Feedback gespielt werden, um bewusst ambivalente Resultate auch aufseiten des Publikums zu erzielen. Zu Hayes’ Werkzeugen für das von ihr angestrebte multimodale Musikerlebnis zählen Open-Source-basierte Software, Game Controller wie beispielsweise der PS2 Controller, 3D-Controller und die Vibrationsfunktion von Mobiltelefonen.

Vor dem Hintergrund seiner audiovisuellen Performances konzentriert sich Kontogeorgakopoulos vornehmlich auf die Entwicklung von Fadern, da sich mit ihnen klangliche Ereignisse intuitiv wie physisches Material dehnen lassen. Auch für ihn ist es entscheidend, die spielerischen Nuancen, die man durch den Gebrauch akustischer Instrumente gewohnt ist, auf digitale Klangerzeuger anzuwenden.

Da man in der nicht-virtuellen Welt das Haptische nicht abschalten könne, gelte es für die Steuerung von virtuellen Klangquellen vor allem physisch erfahrbare Widerstände zu verfeinern. Der damit einhergehende Fokus auf sogenannte Mikrogesten erlaube überdies die Entwicklung audio-haptischer Erlebnisse, die umgekehrt gar nicht mit dem traditionellen Instrumentenbau zu erzielen seien. Erweiterte haptische Steuerungs- und Ausdrucksformen begreifen sowohl Kontogeorgakopoulos als auch Hayes nicht nur als Mittel zum Zweck, sondern als eigenständige Instrumente, deren Technologie genauso erlernt werden muss wie das Spiel akustischer Instrumente.

Dies ist auch als eine Antwort auf die Tendenz zu verstehen, dass viele Hersteller darum bemüht sind, Bedienoberflächen so simpel wie irgend möglich zu gestalten, während es sich aber bei der Haptik eigentlich um eine komplexe Angelegenheit handelt, die viel Übung verlangt. In dem Versuch neue Formen der audio-haptischen Wahrnehmung für Musiker und Publikum gleichermaßen zu erschließen, geht es Kontogeorgakopoulos und Hayes jedoch besonders um die zukunftsweisende Perspektive: Das Ausloten der Möglichkeiten für hybride Instrumente, die in der nicht-virtuellen Welt nicht zu realisieren sind.

Der Zukunftsmusik widmen sich entlang der Themenschwerpunkte generative Musik und künstliche Intelligenz überdies drei Vorträge. Als Einführung hierzu ist Tero Parviainens Präsentation „How Generative Music Works: A Developer’s Perspective“ zu verstehen. Der finnische Software-Entwickler führt hier zunächst durch die Geschichte der generativen Musik und weist gleich zu Beginn darauf hin, dass wer an generativer Musik interessiert sei, sich im Grunde mit der Gestaltung von Systemen befassen müsse. Diese gehen in der Musik auf zwei Ideen zurück: das Maschinenkonzept und die abstrakte Organisation von Zufallsereignissen.

Die maschinelle Methode findet sich in solchen Arbeiten wieder, die sich durch den Gebrauch von Bandmaschinen erzeugte Phasenverschiebungen zunutze machen, so wie etwa Steve Reichs „It’s Gonna Rain“ (1965) oder Brian Enos Music for Airports (1978). Das Prinzip organisierter Schemata ist hingegen charakteristisch für die aleatorische Musik. Als wegweisendes Beispiel gilt hier Terry Rileys „In C“ (1964), das für eine unbestimmte Anzahl von Aufführenden komponiert wurde und als Grundlage für ein generatives System begriffen werden muss, da keine Aufführung und Wiederholung derselben identisch sein werden. Obschon generative Musik ihren Weg auf Tonträger fand, stellt natürlich das Prinzip des Tonträgers das Gegenteil von generativen Prozessen dar, insofern dadurch nur eine Version von Zufallsprozessen fixiert wird.

Um den generativen Charakter eines Systems auch im Produkt zu erhalten, gibt es jedoch längst die Möglichkeit, anstelle eines Albums eine App – also Software –zu veröffentlichen. Ein Beispiel hierfür ist Enos Reflection (2017). Die Erzeugung von Zufällen folgt freilich immer nur den festgeschriebenen Kalkulationen der programmierten Algorithmen und so halten sich die Möglichkeiten auch im Rahmen von interaktiven Modellen – zumindest rein rechnerisch betrachtet – in Grenzen. Jedoch lässt sich das Zufallsprinzip potenzieren, indem man verschiedene Systeme miteinander verknüpft. Parviainens demonstriert dies, indem er das Zugsystem Helsinkis mit einem generativen System zur Erzeugung pentatonischer Skalen kurzschließt. Das Ergebnis sind durch das Halten von Zügen ausgelöste Noten, deren Rhythmus und Tonhöhe vom Zugfahrplan der finnischen Hauptstadt bestimmt werden. Weitere Optionen bieten generative Systeme, die auf maschinellem Lernen basieren.

- Tero Parviainen und sein durch den Zugfahrplan Helsinkis gesteuertes generatives System.

- Nick Collins im Kultursaal.

- Gene Kogan und ein Beispiel der generativen Bildsynthese.

Diesen widmet sich Nick Collins (Durham University) in seinem Vortrag „MusAIcal Corposition: Artificial Intelligence, Large Audio Collections and You“. Zentral sind hier die beiden Neologismen Corposition und musAIc. Corposition bezeichnet die Verwertung großer Audiodatenmengen (eines musikalischen Korpus) zum Zweck des maschinellen Lernens. Damit ist also die Organisation und Verarbeitung von musikalischem Ausgangsmaterial gemeint, anhand dessen eine Software spezifische Kompositionsprinzipien erlernen soll.

So könnte man beispielsweise Bachs gesammelte Oratorien einlesen lassen, falls man auf der Suche nach einem künstlichen Barockkomponisten ist, von dem man sich eine neue Matthäus-Passion erwünscht. musAIc wiederum bezeichnet die Entwicklung künstlicher Intelligenzen, die für Studio- oder Bühnenzwecke eingesetzt werden können, gewissermaßen als digitale Kollaborateure oder Assistenten. Während Collins einige gegenwärtige Projekte vorstellt, die sich automatisierter Audioanalysen und dem Maschinenlernen bedienen, liefert der Programmierer Gene Kogan einen Überblick über derzeit genutzte Technologien sowie den aktuellen Forschungsstand.

Unter dem Titel „Deep Listener: Machine Learning in the Composer’s Future Toolkit“ geht es zunächst einmal darum, wo wir den Resultaten des maschinellen Lernens bereits heute im Rahmen der digitalen Musikproduktion begegnen. Zu nennen wären hier unter anderem die automatisierte Zeitmaßerkennung von DAWs, Spotify-Empfehlungen, das Design standardisierter Bedienoberflächen und die Synthesemethode Physical Modeling. Geläufig beruht das Verfahren, das ebenso für die automatische Stimmenerkennung genutzt wird, auf der Analyse von rohen Mediendaten und daraus extrahierten Patterns.

Das Problem dieser Variante besteht in erster Linie in der zur Verfügung stehenden Zeit, da Musik sequentiell ist und entsprechend verarbeitet werden muss. Dies stellt kein Problem dar, solange die Datenmenge überschaubar ist, jedoch dann, wenn es gilt, ganze musikalische Kataloge oder Sample Librarys analysieren zu lassen. Eine Alternative bieten sogenannte Nerve Nets, die mit einem Faltungscode operieren und Unmengen von Daten in kürzester Zeit analysieren und deren Informationsgehalt wiederverwerten können, beispielsweise für die Stimmensynthese. Neurale Netzwerke wurden zunächst für die generative Erzeugung von visuellen Medien genutzt. Verwendet wird diese Technologie auch von Googles Erkennungssoftware DeepDream. Diese Variante erlaubt nicht nur die Erkennung von Mustern gleichartiger Quellen, sondern auch intermediale Syntheseformen, etwa von Text zu Bild und umgekehrt.

Der andere aktuelle Anwendungsbereich ist im Grunde eine Art von Photoshop für Audiomaterial, wie sie Anfang November 2016 von Adobe in Form der Software VoCo vorgestellt wurde. Damit deutete sich bereits an, dass man in Zukunft in der Lage sein wird, alles und jeden nach Wunsch zu simulieren: Bilder, Stimmen, Musik und vieles mehr. In der Musikproduktion ließe sich diese Option auf die automatisierte Kreuzung verschiedener Genres anwenden oder aber die inhaltsbasierte Sortierung von Samples innerhalb einer DAW. Möglich sind jetzt bereits kreative Steuerungsvernetzungen, wie sie Kogan am Ende seines Vortrags vorführt. Er nutzt drei programmierbare Ebenen, um zwischen Ableton Live, einer generativen Software und seiner iSight-Kamera lernbare Wahrscheinlichkeiten für Performance-Zwecke einzusetzen. So bestimmen in seiner Versuchsanordnung Bilder, die von der iSight-Kamera erfasst werden die Klang- und Parameter-Mappings, die wiederum innerhalb von Ableton Live wiedergegeben werden. Jenseits der interaktiven Möglichkeiten und Syntheseoptionen, die auf dem maschinellen Lernen basieren, stellen sich jedoch auch ethische Fragen, vor allem im Hinblick auf potentielle Missbrauchs- und Manipulationsfälle. Kogan beschreibt den derzeitigen Forschungsstand daher als gleichzeitig faszinierend und erschreckend.

Für die Musikbranche im Speziellen sind die Konsequenzen ebenso weitreichend, da jede inhaltsbasierte Musikerkennung letztlich die Bedeutung von Genres abschaffen werde, sobald eine jede zufällige Kreuzung möglich ist. An die Stelle der von Spotify empfohlenen Vorschläge könnten künftig generativ erzeugte Stücke treten, die automatisch anhand jeweiliger musikalischer Vorlieben erzeugt werden. So oder so wird man sich in wenigen Jahren der Frage stellen müssen, wer oder was ein Musiker oder Komponist ist und welche Rolle man anstelle tradierter Vorstellungen einnimmt.

Neue alte und alte neue Klänge

Bereits in der Diskussion „Code the Boutique“ betonte der Moderator Rory St. John (er organisiert Abletons Sound Packs), dass Presets nicht nur dabei helfen, ergebnisorientiert zu arbeiten, sondern auch eine gute Ausgangsbasis für das Erlernen von Sound Design seien. In dem Gespräch, das Peter Kirn unter dem Titel „Listening: The Secret of Sound Design“ mit dem Sound Designer und DJ Francis Prève führt, wird dieses Motiv erneut aufgegriffen, jedoch vor allem gegen den Strich gebürstet. Prève startet das Gespräch mit einem Witz: dem Anspielen von John Cages „4’33“. Dass es ihm mit diesem Stück jedoch ernst ist, in dem über 4 Minuten und 33 Sekunden niemand etwas spielt, sondern das Publikum nur sich selbst und den Umgebungsgeräuschen überlassen ist, wird durch das belegt, was Prève derzeit als Preset favorisiert: Natur- und Umweltgeräusche.

Dem Entwerfen von oftmals standardisierten Synthesizer-Sounds nach 35.000 Berufstagen müde geworden, begann Prève vor einiger Zeit mit der Arbeit an seinem Scapes Project, über das Kirn bereits im Sommer letzten Jahres auf seinem Blog Create Digital Music berichtete. Das Scapes Project, das auch als Download in Form von Ableton Projects zur Verfügung steht, lässt sich im Grunde als eine Sammlung von Fake Field Recordings beschreiben. Die darunter versammelten Klänge, die allesamt mit Abletons Operator erstellt wurden, simulieren auf atemberaubend überzeugende Art und Weise alle möglichen Natur- und Umweltgeräusche, von Regenschauern bis hin zu Schritten auf einem Bürgersteig.

Prèves Ausgangspunkt war die Frage, wie wir Klänge um uns herum wahrnehmen und ein darauf gründender Dechiffrierungsprozess. Sein Projekt verdeutlicht überdies, dass es sich beim Sound Design um eine Sprache handelt, deren Grammatik sich aus verschiedenen harmonischen Charakteristiken zusammensetzt. Als anschauliche Beispiele nennt Prève hier Wände und Türen, die geläufig wie Tiefpassfilter wirken, während sich Wind und Wellen mit weißem Rauschen erzeugen ließen.

Aus denselben Gründen werden für das konventionelle emulative Sound Design Sägezahnwellenformen für Streicher und Bässe genutzt, während man sich für Flöten der Rechteckwellenform bedient. In diesem Sinne ist Prèves Scapes Project nicht nur als eine radikale Rückbesinnung auf das zu verstehen, was die eigentliche Grundlage des Sound Designs bildet, nämlich das Zuhören, sondern auch als Ermutigung, auf dieser Basis seine eigenen Wege jenseits abgestandener Standard-Presets zu gehen.

Preset-freie Analogsynthesizer oder Modularsysteme können hierfür als besonders geeignete Instrumente gelten, da sie aufgrund der nicht unmittelbaren Wiederherstellbarkeit von einmal verstellten Sounds ein höheres Maß an Konzentration einfordern. Jedoch handele es sich dabei nicht um ein Allheilmittel, das es verdient einer Software als originellere Version entgegengesetzt zu werden – vor allem nicht, wenn man sich ein Modularsystem nur aus dem Grund anschafft, um davor zusammen mit seiner Katze willkürlich Kabel zu vertauschen, wie Prève scherzhaft anfügt. Im Mittelpunkt stehe stattdessen, dass man gewillt ist, das Zuhören zu lernen und gelernt habe man erst dann etwas, wenn man es mindestens einmal wiederholt habe. Schließlich koche man ja auch nicht nach dem Zufallsprinzip.

- Kaki King – The Neck is a Bridge to the Body.

- Visible Cloaks in Concert.

- The Nile Project Performance.

- Jenny Hval in Concert.

Jenseits der Lehrpläne

Um das Lernen und zukünftige Generationen gleichermaßen geht es schließlich in dem Panel „Beyond Curriculum: New Perspectives in Music Education“. Die etwa dreistündige Diskussion ist zweigeteilt. Im ersten Abschnitt spricht der Produzent und Dozent Tony Nwachukwu mit Vertretern aus Bildungsinstitutionen, im zweiten Abschnitt leitet der Komponist und Autor Dennis DeSantis die Debatte mit Künstlern, die außerhalb gängiger Bildungsformate mit Jugendlichen arbeiten. Im Zentrum der ersten Diskussionsrunde steht die Frage, wie man aktuelle Musiktechnologien in Klassenzimmern und Seminarräumen integrieren könne.

Den Hintergrund bildet die Tatsache, dass traditionelle Lehrpläne, die in erster Linie auf einer antiquierten Vermittlung musiktheoretischer Grundlagen fußen, nicht nur für ein ausgesprochen geringes Interesse sorgen, sondern außerdem wenig mit der Realität gegenwärtig praktizierter Musik zu tun haben, weder im soziokulturellen, noch im technologischen Sinne. Will Kuhn, Leiter des Departments für Musiktechnologie an der Lebanon Highschool, Ohio, überzeugte vor wenigen Jahren in Eigeninitiative seine Schulleitung von der Notwendigkeit eines Musiklabors als Ergänzung zum Standardkurrikulum der Musikabteilung, in der er zunächst als Dozent beschäftigt war. Nach Bewilligung seines Förderantrags, stattete er einen ungenutzten Seminarraum mit Computern, Push- sowie MIDI-Controllern aus und verfasste einen Lehrplan für die digitale Musikproduktion und entsprechende Gruppenprojekte. Seither unterstützt er seine Studierenden nicht nur bei der Verwirklichung eigener musikalischer Ideen und der Organisation eines Campus-Musikfestivals. Kuhn kreiert mit ihnen auch Videoprojekte, die unter anderem eine Parodie auf das Film-Musical La La Land und einen subversiven Werbefilm für das etwas verschlafene Lebanon einschließen. Der daraus resultierende Vorteil für die Studierenden besteht vor allem darin, dass sie mit ihrem BA-Abschluss auf eine Vielzahl von Medienkompetenzen verweisen können, die fachübergreifend einsetzbar sind.

Der aus Houston, Texas, stammende Aragorn Eissler verfuhr ähnlich. Aus seiner Position als Vertretungslehrer heraus, richtete der ehemalig freischaffende Musiker ebenfalls einen Seminarraum für die digitale Musikproduktion ein. Auf Basis reformpädagogischer Konzepte unterrichtet er anwendungsorientiert und in kollaborativen Formaten, was auch die Erstellung von Remixen mit originalen Stems einschließt. Zentral ist für Eissler, dass er seinen Schüler und Schülerinnen genügend Zeit für das engagierte und konzentrierte Arbeiten gibt und er sich nicht stur an vorgegebene Lehrpläne halten muss, ungeachtet der Fragen, die sich jederzeit im Klassenraum stellen können. Zudem fügt er an, dass niemand besser geeignet für das Unterrichten sei, als diejenigen Musiker, die sich aus eigener Erfahrung der materiellen sowie kreativen Probleme und Blockaden bewusst seien, da gerade die eigens erfahrenen Kämpfe für die Probleme anderer sensibilisieren.

- Aragorn Eissler, Victoria Armstrong, Will Kuhn und Moderator Tony Nwachukwu.

- Hussein Sherbini, Max Wheeler, Melissa Uye-Parker und Moderator Dennis DeSantis.

Als weniger optimistisch erweist sich der Blick auf die Situation in Großbritannien, wo die Bildungsinstitutionen staatlichen Regularien unterworfen sind und für Eigeninitiativen an eingefahrenen Bildungsinstitutionen keinerlei Spielräume bleiben. Der Situation in Deutschland vergleichbar, gilt auch hier das Primat der sogenannten MINT-Fächer. Als Vertreterin ist hier Victoria Armstrong, Direktorin des Instituts für Pädagogik und Sozialwissenschaft der St. Mary’s University, London, geladen. Sie hält fest, dass die Richtlinien für die schulische und universitäre Ausbildung in erster Linie an der Fähigkeit ausgerichtet seien, wie man am besten Tests bestehe, und Fächer wie Musik oder Kunst nicht als Teile des Kernlehrplans gelten. Die Schulung von künftigen Musiklehrern sei überdies in der Regel höchst unspezifisch – das heißt nicht forschungsorientiert – und im Hinblick auf neue Technologien völlig unzureichend. Zudem fehle es den Schulen und Universitäten an den nötigen Ressourcen, mithilfe derer man Seminarräume mit zeitgemäßem Equipment ausstatten könne.

Dass im Falle solch verfahrener Situationen mögliche Alternativen in außerschulischen oder außeruniversitären Kollaborationen mit Künstlern und Produzenten aus der Musikbranche zu finden sind, zeigen die drei Gäste der zweiten Diskussionsrunde. Zu ihnen zählen der Produzent Hussein Sherbini, der in Kairo mangels erschwinglicher Angebote sein eigenes Studio eröffnete, das er dort mit Seminaren zur digitalen Musikproduktion finanziert, der britische Produzent und Mitbegründer des Duos Anushka Max Wheeler, der kürzlich an einer Grime-Oper mit dem Künstler Eyez und dem Jugendorchester Essex mitwirkte, und die britische Songwriterin und Dozentin Melissa Uye-Parker, die ihn London musiktechnologische Seminare anbietet und sich mit der Frage des Ungleichgewichts zwischen den derzeit technologischen Möglichkeiten und deren Abwesenheit an Bildungsinstitutionen auseinandersetzt.

Alle drei sprechen sich für eine notwendige Reform derzeitiger Lehrpläne aus und problematisieren die Technikphobie, die eine jegliche Neuausrichtung blockiere. Sie resümieren, dass die traditionelle Musikterminologie und Vermittlungsweise musiktheoretischen Wissens in erster Linie der Abschottung und Exklusion dienen. Stattdessen seien begriffliche sowie technologische Barrieren auszuräumen und auch Lehrer dahingehend zu ermutigen, dass die digitale Musikproduktion nicht spezifischer Kenntnisse bedarf, sondern es vielmehr um eine spielerische Denkweise gehe. Hinsichtlich der Schüler sei hingegen darauf zu achten, dass man Endprodukten nicht den Vorrang gegenüber dem Lern- und Produktionsprozess einräume und Fehler zulasse. Auch eine Knappheit finanzieller Mittel müsse kein Hindernis darstellen.

Zum einen, weil viele Musik-Apps mittlerweile sehr günstig oder kostenlos erhältlich seien, zum anderen, weil beispielsweise Genres wie Rap lediglich einiger Beats und Texte bedürfen, wie Wheeler betont. Dass am Ende eine entspannte Victoria Armstrong auf dem Podium steht, lässt hoffen, dass diese Vorschläge auch über Loop hinaus Gehör finden.

- Gut versorgt dank Kantine und Milchbar.

- Gut versorgt dank Kantine und Milchbar.

Und was ist mit Ableton Live 10? Diese Frage stellten sich seinerzeit in Online-Foren viele User, die davon ausgingen, Loop 2017 sei in erster Linie um eine entsprechende Präsentation herum konzipiert worden. Aber obschon Live 10 auf allen zugänglichen Computern anzutesten war, spielte die eine Woche vorher angekündigte Neuauflage der DAW nur ganz am Rande eine Rolle, nämlich vorwiegend in einem Durchgangsbereich, in dem auch andere Hersteller mit ihren Produkten präsent waren.

Dies erwies sich als große Stärke, vermied es doch den Eindruck, man sei in erster Linie zu Gast auf einer Werbeveranstaltung, auf der alles weitere nur dekorative Zwecke erfüllt. Dass die Marke Ableton nicht im Mittelpunkt stand, erlaubte schließlich einem breitgefächerten Angebot von thematisch übergreifenden und teils widerstreitenden Diskussionen Platz auf den Bühnen zu nehmen. Und mehr kann man sich von einer weiteren Loop wirklich nicht wünschen.

Ganz schön verkopft, kann ich nicht viel damit anfangen, und Milchbar? Ehrlich jetzt? Fühle mich da als, wie war das noch, Musikschaffender nicht repräsentiert.

Meine Welt auch nicht. Werde wohl alt. :)

Musik mag für den einen oder anderen irre mit Sozialthemen etc. aufgeladen sein, aber irgendwie kann das dann eine anstrengende und überstrapaziert beliebige Angelegenheit werden. Zumal Themen wie potenzielle Demokratisierung der Szene durch billige Technik bald 20 Jahre alt sind und auch das Geld- und Marketingproblem im Internet brennt seit mindestens 10 Jahren schwerstens und weiterhin „ungelöst“. Es wurde zwar schon alles gesagt, aber noch nicht von jedem. Irgendwann wirds zu schwurbelig.

Warum nicht einfach mal nur geilen bewegen Sound zu machen, statt endlos über Bedeutungen zu labern?

Aphex Twin on the nature of electronic music:

https://youtu.be/7UUsHrDKNH0

phhhhh…. eigentlich wollte ich da immer mal hin. Nicht nur weil ich jetzt seit 25 Jahren elektronische Musik mache, mich sehr viel mit Controllern beschäftige (sogar eigene baue), durchaus theoretische konzepte zu schätzen weiß und überhaupt…. aber nach dem Bericht, nein Danke. Vielleicht war es nur die Zusammenstellung des Autors – man kann ja schließlich nicht alles besuchen – aber die ersten 4 Seiten sind für mich irrelevantes Verkaufstaktiken/Positionier Dich Geschwurbel. Bei Seite 5 wirds mit Haptik als Rückmeldung für Controller interessanter – da komme ich aber in 10 Minuten Youtube weiter als das, was die da erwähnen. Seite 6 mit zufallsbasierter Musik und neuronalen Netzwerken ist ebenfalls interessant… aber dann geht es schon wieder um Musiklehrer. Boah…gähn! (Und das sage ich, der ständig auf internationalen Konferenzen ist – Wissenschaftliche Betrachtung von Mensch-Maschine-Interaktion… da werden dann aber Modelle, Ergebnisse, Ideen präsentiert und so wie ich den Bericht auffasse gehts bei der Loop eher um Stuhlkreise und Gefühle…. sorry, das war jetzt hart) Schade, ich hätte mir mehr konkrete Tutorials versprochen: Wie erzeuge ich dies oder jenes, tricks mit Ableton (oder auch anderer Software) usw…

@tonvibration Respekt!

Ich hab es nur bis Seite 2 geschafft. Bin aber auch kein Literatur-, Theater- und Musik“wissenschaftler“.

@digital-synthologie Ja man hätte diesen Bericht splitten sollen. Das ist einfach brachiale Breitseite.

Eine Serie daraus und man liest das auch ganz durch. Ich schätze so werden die meisten irgendwann das scrollen anfangen nur noch Textfetzen querlesen und danach ist der gute Artikel in der Versenkung. Die grossen Bilder sind einem Leserythmus auch eher abträglich, finde ich. Lieber kleiner mit Option zum grossen Popup.

Ist ja richtig schade um die große Mühe des Autors.