Take the Beat higher!

Das Flesh Ensemble – ein performatives Instrument für Reaktor 6 – generiert aus Drum-Samples harmonische Bässe, Melodien, Akkorde und Sequenzen. Daher wohl auch der Name, der das „Fleisch auf die Knochen“ bringen soll. Schon mit seinen Vorgängerprodukten The Mouth und The Finger war klar, dass Tim Exile für Allerweltseffekte nicht zu haben ist. Native Instruments Flesh ist nun das dritte Produkt, das die Software-Schmiede aus Berlin von Tim veröffentlicht, nachdem er mehrere Jahre daran gefeilt hat. Ob man mit Flesh nun einen Hardbody oder einen üblen Bodymaß-Index bekommt, lesen sie im Test.

Flesh ist ein Reaktor-Ensemble, eine Patch-Datei, die zum Betrieb den kostenlosen Reaktor-Player oder die Vollversion von Reaktor 6 benötigt.

Flesh ist nur als Download verfügbar und hat eine Größe von ca. 300 MB. Nach der Installation belegt die Software dann knapp 700 MB auf der Festplatte. Flesh wird über das Service Center, Native-Instruments eigenes Kopierschutzsystem, aktiviert. Ausführliche Hilfe zur Installation und zur Bedienung findet sich im englischsprachigen PDF-Handbuch, das auf der NI-Website zu finden ist.

Effekte, die über Slicing-, Glitch- und Stutter-Effekte aus melodischem Audiomaterial Beats machen, sind ja schon länger und mit stattlicher Anzahl bekannt. Audio Damage Automaton, SonicCharge Permut8, Sugarbytes Effectrix oder iZotope BreakTweaker und Stutter seien hier stellvertretend genannt. Effekte oder Instrumente, die aus einem Drum-Sample aber harmonische und melodische Anteile herauszuziehen und aufbereiten, sind schon wesentlich dünner gesät. Genau genommen fällt mir auf Anhieb keines ein. Wer sich bemüßigt fühlt, mich zu aufzuklären, darf das gerne in den Kommentaren tun. Kurz gesagt: Die Idee ist zumindest noch ziemlich unverbraucht.

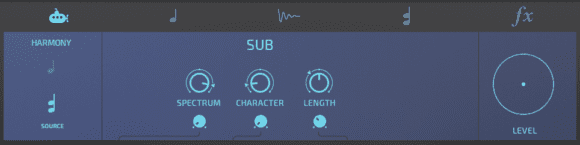

Flesh besteht aus fünf Modulen. Das blaue U-Boot des (Sub-) Basssynthesizers, …

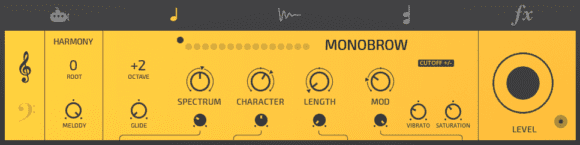

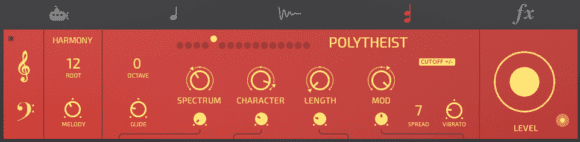

der gelbe Monosynthesizer und der rote Polysynthesizer analysieren das Sample-Set auf ihre Frequenzen und generieren daraus die Basisnoten.

Die Module sind meistens gleich aufgebaut und mit den zentralen Parametern Spectrum (für die Bandbreite der Frequenzanalyse) und Character (zur Verstärkung von Frequenz- und Dynamikeigenheiten des analysierten Samples, d.h. letztendlich zur Erzeugung von Artefakten) ausgestattet. Je mehr Character, desto wilder wird der Sound. Und schließlich noch der Parameter Length, die Trigger-Hüllkurve, die die Releasezeit für die erkannten Noten angibt.

Die Synthesizer haben noch weitere Parameter, wie beispielsweise die Oktavlage und ob die Synths von höheren und/oder tieferen Bassfrequenzanteilen getriggert werden, um Noten zu erzeugen. Der Melody-Parameter bestimmt, wie viele zusätzliche Noten durch die Transienten des Samples erzeugt werden. Der Parameter ist bipolar und die Einstellung erzeugt entweder eine negative oder positive Modulation der Tonhöhe.

Der elfenbeinfarbene Sample-Player funktioniert zwar genauso wie die anderen Module, jedoch beeinflusst er das gespielte Sample direkt. Die Modulationsparameter, über die alle Module verfügen, erzeugen hier besonders tiefgreifende Effekte, da die anderen Module ja selbst von den Samples abhängig sind. Aufgrund der angewendeten Granularsynthese für jedes Slice können hier selbst extreme Veränderung ohne große Klangeinbußen bewerkstelligt werden.

Schließlich gibt es noch das Effekt-Modul. Das Modul ist eine Kombination aus einem Dub-Delay mit zwei tempoabhängigen Delay-Lines samt Filter und Limiter. Die akustische Auswirkung ist ebenfalls von den Hüllkurven und den Modulationen, die aus dem Sample-Material extrahiert werden, abhängig. Der (Send-)Anteil, der von den anderen Synthesizern in die Effekteinheit gelangt, kann über die drei kleinen Kreise ganz links geregelt werden.

Alle Module haben jeweils 16 feste Presets für verschiedenste Klangvariationen eingebaut, diese sind alle im Handbuch ausführlich beschrieben. Fast jeder Parameter ist über den internen LFO modulierbar, wobei sowohl die Modulationstiefe als auch der Modulationsbereich festgelegt werden kann.

Mit „garbage in – garbage out“ hast du vollkommen recht. Leider mögen sehr viele diesen Garbage, wenn er nur fett klingt.

Und das gilt sowohl für die Konsumentenseite (im Bereich EDM geschätzt >99%), wie auch im Hobby- bis SemiPro-Musikerbereich. Und der Pro-Bereich kann sich dem letztendlich nur schwerlich verschließen, und schon kommt überall der gleiche Senf raus. Und um das zu verschleiern, werden ständig neue Dance-Stilarten erfunden, gerne auch mit dem Präfix „Progressiv“, auch wenn die Mucke dahinter maximal davon entfernt ist.

Mir persönlich ist das relativ egal, da ich nicht in diesen Sparten unterwegs bin, weder als Hörer noch als Musiker. Ich find es aber für alle Seiten mehr als schade, weil in einer solchen Umgebung jeder Hauch von echter Kreativität schnell erstickt, bzw. durch Scheinkreativitätsaktionen überlagert wird. Die Leutz, die die ersten Wobbelbässe noch handgestrickt haben, haben was erschaffen. Die nächste Generation hat vielleicht noch mit dem Element gespielt und etwas ausprobiert. Die große Masse danach lässt den Kram einfach mit ihren Tools und Synthie-Features erzeugen und hinterfragt es noch nicht einmal ansatzweise, sondern pflegt es als Dogma wie die stumpfe Kick auf im VierViertel.

Sehr gut beschrieben! Danke für deine Worte. Darum Finger weg von diesen Tools. Selber machen und dabei lernen! Dann wird die Musik wieder interessanter.

Daher sollte man durchaus solche Malen-nach-Zahlen-Tools kritisch betrachten, denn sie schaffen zwar vermeintliche Quick-Wins für den enthusiatischen 12jährigen oder den handwerklich nicht besonders begabten 22jährigen, aber Musik kommt leider nur bei denen raus, die es auch ohne diese Tools schaffen würden….

Wie heißt es doch so schön? Viele Wege führen nach Rom… Warum soll man sich nicht mit einem Tool mit einem One-Klick den Arbeitsprozess vereinfachen? Am Ende zählt halt doch nur das Ergebnis und es fragt keiner „wie hast Du das gemacht?“.

Wofür wurde sonst z. B. die Automation erfunden?

Ich gebe Dir aber absolut Recht: Man sollte das, was dahinter steckt auch verstehen!

Und evtl. sogar dann auch mal einen anderen Um-Weg versuchen ;-)

@GEM-D Genau das ist das Grundproblem aus meiner Sicht. Dass schlicht alle Wege nach Rom führen, bzw. führen müssen. Also nicht solche Tools meiden, weil sie Dinge vereinfachen; das finde ich völlig OK. Man sollte sie meiden, weil sie letztendlich doch meist in den gleichen schlichten Sound münden. Nichts gegen Hilfen, aber halt gegen Malen-nach-Zahlen….

schade, das es keine klangbeispiele gibt um das abstrakte etwas zu veranschaulichen, so hat man nur eine ahnung, was flesh denn eigentlich kann.

ich sehe natürlich auch die gefahr, dass ein solches programm futter für die – mich schon seit jahrzehnten nervende – „echte musik ist handgemacht“-fraktion ist, die sich ja dann gerne auch mal auf die dance-schiene einschiesst. man liest es ja auch hier in den kommentaren.

wer es allerdings wagt, den wert von musik pauschal zu beurteilen und glaubt, irgendein genre sei frei von dogmen, scheint schon ganz schön bodenhaftung verloren zu haben!

@dilux Nur zur Ergänzung: Ich will hier keineswegs dieses von dir ins Spiel gebrachte Fass aufmachen, denn dieses Ding interessiert mich nicht. „Handgemacht“ ist ein Argument von Leuten, die grundsätzlich Probleme mit bestimmten Techniken haben. Aber an dieser Stelle verstehst oder interpretierst du mich falsch. Ich hab auch nichts gegen EDM, die gerne auch IDM sein darf, wo immer auch die Grenze gezogen werden kann. Und ich persönlich mag auch Musiker, von Orbital bis zu PlanningToRock, von Mouse on Mars bis The Knife. Alles großartige Musiker, die aus solchen Tools tolle Dinge rausholen könnten, wenn sie denn damit arbeiten würden, und zwar weit jenseits der Stereotypen, zu denen solche Tools halt verleiten. Aber bei klassischer Funktionsmusik, wie sie in Clubs benötigt wird, spielt das wohl eher eine untergeordnete Rolle. Und ja: Man kann sehr wohl von Funktionsmusik sprechen, ohne dies abwertend zu meinen. David Guetta z.B. wird wohl kaum auf die Idee kommen, seine Musik mit beispielsweise Autechre zu vergleichen. Beide machen Musik zum Tanzen, aber bei dem einen geht es halt darum, dieses möglichst multifunktional, sprich bei einem maximal großen Publikum zu erreichen. Und das klappt auch, also alles bestens. Dass das selbstverständlich nur auf dem kleinsten gemeinsamen Nenner funktioniert liegt auf der Hand.

ok, so weit so gut, ich will auch gar nicht zu weit ins theoretisieren kommen, aber bei 2 punkten würde ich dich gerne ins nachdenken bringen:

funktionsmusik ist für mich eigentlich jede form von (moderner) musik insofern, dass sie dahingehend funtioniert, dass sie beim zuhörer emotionen hervorruft…so funktioniert techno z.b. bei mir auch daheim auf dem sofa.

zu deiner theorie bzgl. guetta und autechre – hier wollte ich kurz anfügen, dass ich wesentlich näher an autechre bin, als an guetta ;) – glaubst du nicht, dass beide die musik machen, die ihnen persönlich entspricht und gefällt? ich bezweifle, das guetta mit dem hintergedanken „was gefällt den massen“ ins studio geht, ich glaube sogar, so funktioniert das einfach nicht. guettas künstlerischer output spricht einfach den breiteren querschnitt an als autechres…

@dilux hallo dilux,

sorry wg. Audiodemos, aber der Test musste superschnell fertig werden.

Es gibt aber eine Demo zum selber testen:

http://www.native-instruments.com/de/products/komplete/synths/flesh/demo-version/

viel aussagekräftiger, IMHO.

Grüße,

M. :)

Teil 1

Aufgrund er Kommentare und als Anhänger von generativer und algorithmischer Musik möchte ich doch noch einige Ansichten anhängen:

In der elektronischen Musik, besonders in der akademischen, ist manchmal der Algorithmus oder Prozess das Kunstwerk und nicht das Ergebnis.

Als langjähriger Reaktor-Nutzer räume ich natürlich ein, dass ich der Technikbegeisterung, sowie dem Interesse und Verständnisses am Prozess an sich, mindestens so viel Bedeutung beimesse wie dem Ergebnis.

Und hier schafft es das Ensemble denjenigen zu überraschen, bei dem es mir das immer am schwersten fällt : mich.

Deswegen ich lasse auch viel lieber Melodien und Harmonien kontrolliert kontinuierlich generieren. Aich musiktheoretisch abzurackern, gibt mir nichts. Ich bastel lieber an frickeligen Beats und Klängen und genau dafür finde ich Flesh super.

@Markus Schroeder Teil 2

Außerdem, um die Automation (und Klangaufspaltung) ging es doch in der elektronischen Musik seit ihrer Erfindung.

Das sie später u.a. mit Hilfe von Herrn Moog von klassischen Musikern „gekidnapped“ wurde und heutzutage vieles für „elektronisch“ (kann nicht mit mechnischen Instrumente nachgespielt werden) gilt was nur „elektroaffin“ (kann mit mechanischen Instrumenten nachgespielt werden) ist, steht auf einem ganz anderen Blatt und das Argument „Musik muss handgemacht sein“ greift hier sowieso ins Leere.

Jeder gesyncte LFO, jeder Arpeggiator und Step-Sequencer, jeder Ableton-Clip nimmt Dir die Kontrolle aus der Hand. Von den ganzen MIDI-Tools und automatischen Quantisierungen ganz zu schweigen. Beschwert sich jemand darüber?

Flesh macht hier auch nichts anderes als ein muskalisches Ereigniss in ein

anders umzuwandeln. Wenn die Anwender damit nur lahmes Zeug machen

liegt das nicht am Werkzeug. Das Flesh ein solche Verhalten begünstigt will ich gar nicht bestreiten. Aber man sollte Ursache und Symptom nicht verwechseln.

Der einzige wirkliche Kritikpunkt an Flesh ist für mich nur, dass es nur eine Skala mit 12 Tönen gibt.

Grüße,

M. :)

@Markus Schroeder Ich denke, wir sind hier nicht wirklich weit auseinander. Daher hab ich meinen ursprünglichen Kommentar auch auf die Gefahr von absolut standardisierten und ideenlosen Output gemünzt. Jeder wie er mag gilt immer, und wenn das Musizieren an sich das Leitmotiv ist: Umso besser.

Nur der Musik und der musikalischen Weiterentwicklung tut es halt nicht gut, wenn mir ein Tool das abnimmt, was ohnehin die Dancecharts schon überschwemmt. Die Software, die für mich wobbelt, trapped, Flächen zerhackt oder sonstigen Standardkram abnudelt hält mich letztendlich davon ab, etwas Neues zu erschaffen. Weil das Denken sehr stark schematisiert wird. Aber das ist selbstverständlich nicht das Problem des Tools, sondern des Anwenders. Und genau deshalb sollten solche Tools mindestens gleichberechtigt ins Experiment wie in den Chartbaukasten leiten.

Ja, Andreas, das sind wir definitv im gleichen Boot.

M. :)

@Markus Schroeder Ich finde generative und algorithmische Konzepte auch sehr spannend. Habe mich in der visuellen Gestaltung ein wenig mit Dingen wie emergence, cellular automata etc beschäftigt, aber noch nicht die richtige Herangehensweise & Werkzeuge gefunden, um so etwas für die Ohren zu „generieren“. Wäre das nicht mal eine Idee für einen Workshop? :-)

@OscSync Zum Einlesen:

http://www.amazon.de/Die-freigelassene-Musik-Schriften-John/dp/3902665408/ref=sr_1_1?s=books&ie=UTF8&qid=1454938297&sr=1-1

Ist es nicht egal, aus was ein amusikalischer Müll herauskommt, ob aus einer jenem ‚Flash‘, aus einer Gitarre oder einem Synth, ob analog oder digital. Über Musik wird innerhalb der Pop-Szene ohnehin kaum gesprochen, allenfalls über Klang. Es würde sich auch kaum lohnen ;-)

Generative und algorithmische Konzepte – die aus einer völlig anderen Richtigung stammen -, hatten ihren Höhepunkt in der sogenannten seriellen Musik: Musikalisch Neues hätte nach meinem Ermessen diese Tradition zu überwinden …

@MidiDino Als ein aktueller komponist, der generative und algorithmische Konzepte verfolgt, kann Karlheinz Essl angeführt werden, hier knapp erläutert durch Florian Hartlieb: http://essl.at/bibliogr/hartlieb-positionen.html

Flesh ist ein geniales Tool. Der Beat muss ja nicht immer an sein und es dürfen auch andere Loops als nur Drums geladen werden. Wichtig ist die einzelnen Module zu verstehen und wie die untereinander agieren. Ich hoffe es kommt noch ein Update mit Verbesserungen im Handling und Workflow. Wenn ich etwas Zeit finde kann ich mal schauen ob die Midisignale irgendwie nach aussen zu bekommen sind.

Ich hab die Demo probiert und das Teil ist schon interessant. Nicht zustimmen kann ich aber der Aussage „Effekte oder Instrumente, die aus einem Drum-Sample aber harmonische und melodische Anteile herauszuziehen und aufbereiten, sind schon wesentlich dünner gesät. Genau genommen fällt mir auf Anhieb keines ein.“ Denn ein Beispiel wurde bereits am Anfang des Artikels erwähnt: The Mouth von Tim Exile klingt ganz ähnlich und macht auch vom Prinzip das gleiche, nur dass ich das zu bearbeitende Sample nicht laden muss, sondern einfach eine Audiospur im Sequencer als Quelle nehmen kann. Verbogen wird ebenfalls auf Basis von Frequenzanalyse und neben dem Vocoder sind zwei ähnlich einstellbare Synthesizer- und ein Effektmodul vorhanden.